硅基流动x华为云推出基于昇腾云CloudMatrix超节点的DeepSeek-R1

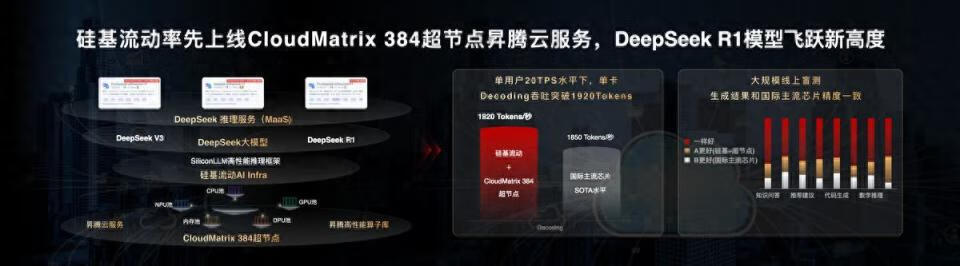

4 月 10 日,硅基流动创始人袁进辉在华为云生态大会上宣布,硅基流动联合华为云基于 CloudMatrix 384 超节点昇腾云服务和高性能推理框架 SiliconLLM ,用大规模专家并行最佳实践正式上线 DeepSeek-R1。

该服务在保证单用户 20 TPS 水平前提下,单卡 Decode 吞吐突破 1920 Tokens/s,可比肩 H100 部署性能。同时,经过主流测试集验证及大规模线上盲测,在昇腾算力部署 DeepSeek-R1 的模型精度与 DeepSeek 官方保持一致。

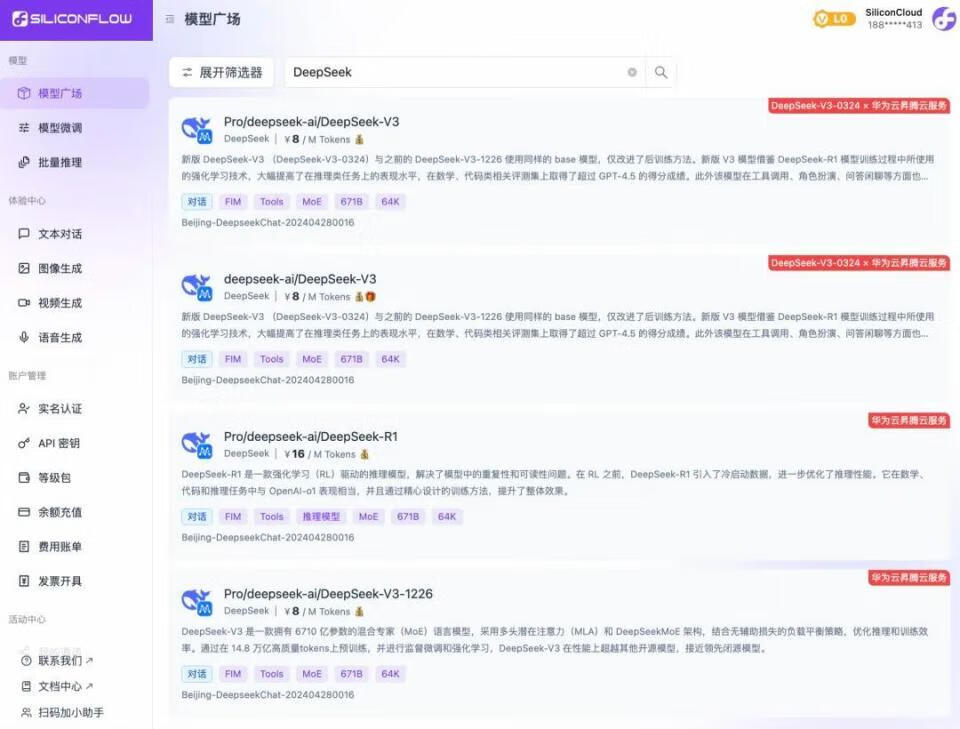

此前,硅基流动在大模型云服务平台 SiliconCloud 首发推出了基于昇腾云的稳定生产级 DeepSeek-V3 & R1 推理服务,并支持模型私有化集群部署,这次合作推动基于国产算力的 DeepSeek-R1 推理服务持续升级。

DeepSeek 风暴席卷全球,特别是以其高效、低成本的 MoE 架构为应对大模型推理挑战打开了局面。不过,如果没有强大的 AI Infra 技术能力,要想部署好 DeepSeek 并非易事。

DeepSeek 使用了大规模专家并行(Expert Parallelism,大 EP 并行)的 MoE 模型架构,若采用单机部署方案,最终的性能远不如 DeepSeek 官方公布的部署方案,且至少有数倍成本差距。更具挑战的是,虽然 DeepSeek 公开了大 EP 并行方案,但技术难度较大,业内还没有其他团队快速复现这一部署方法。

针对这些难题,硅基流动与华为云联合攻关实现了技术突破。首先,通过架构的全面创新,华为云发布的基于新型高速总线架构的 CloudMatrix 超节点集群在总算力、互联带宽、内存带宽上领先业界。其次,双方团队在 CloudMatrix 384 超节点昇腾云服务上部署 DeepSeek-R1 时采纳了大规模专家并行方案,通过多专家负载均衡和极致通信优化,实现高吞吐及更高性能,大幅提升了用户体验。同时,我们使用昇腾高性能算子库,以及硅基流动推理加速框架 SiliconLLM 在模型、机制、算子上的协同优化,实现在国产算力上,不损失模型精度的情况下, 获得 DeepSeek-R1 推理效率与资源利用率的显著提升。

硅基流动与华为云的合作不仅提供坚实的全国产软硬件体系部署方案,让 DeepSeek 推理服务更经济高效,也展现了 AI 生态合作的强大能量,期待更多企业强化生态合作,推动 AI 产业应用落地。