阿里巴巴向谷歌看齐

阿里巴巴站在了“AI泡沫论”的反方,但它并不是在巩固英伟达的市场逻辑,而是越来越像谷歌,讲述全栈式AI为王的叙事。

在AI时代,对于阿里与谷歌而言,前沿大模型相当于“下一代操作系统”,AI算力基础设施相当于“下一代计算机”,旗下业务生态成为了验证与兑现AI价值的关键场景。回望互联网时代,市场往往将阿里与亚马逊并称,它们都以零售为核心,以云为支撑。

历经三年时间,谷歌Gemini 3已经成功赶上了OpenAI;阿里则成为开源模型领军者,性能近乎追平前沿闭源模型,新加坡国家AI计划甚至准备放弃Llama转投阿里Qwen。亚马逊还没有拿出自己的前沿大模型。

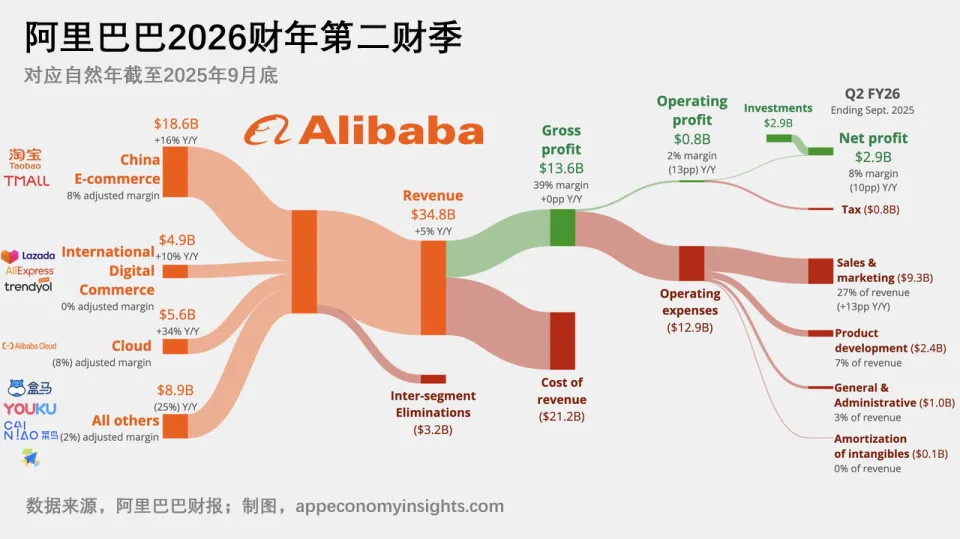

云业务的增长曲线,也印证了参照系的变化。昨晚,阿里发布截至9月底的财报,单季度营收2478亿元人民币,略高于市场预期。其中,尽管云智能集团营收占比约16%,但同比增长34%,领跑电商等其他业务板块。这样几乎与谷歌同频。最近一个季度,谷歌云业务营收占比与同比增速分别约为15%与34%。

阿里明确将基础模型预训练放在首要位置,然后才是推理算力的供给;公司内部业务以及外部客户对阿里AI能力的调用,要放在这两者之后。阿里高管相信AI仍然处于早期阶段,相比短期收入的增长与结构变化,他们更关注基础设施所产生token的总体质量以及token的性价比。

这符合token经济学的规律。模型性能的每一次突破,意味着解锁新的高价值场景,也就带来了token消耗量与token价值的提升;客户为这些token付费的意愿与黏性也将增强;AI工厂的经济性也更强。在电话会议上,阿里强调,非常重视面向全球用户,24小时满负荷地生产更多token的能力。

但是,这一资源配置的优先级,也侧面反映了阿里当前算力供需的紧张状态。这支撑了阿里对“未来三年不太存在AI泡沫”的判断。

当前,包括阿里在内的全球大型云厂商,都处在算力吃紧的状态。上一代、甚至五年前的GPU,都仍在满负荷运行。阿里AI服务器的上架节奏,严重跟不上客户订单的增长速度,在手积压订单规模还在持续扩大。同时,今年下半年开始,全球AI服务器供应链的各个环节,都面临缺货问题,产能瓶颈受限。而从扩产到量产,至少又需要两到三年的时间。

因此,阿里承认之前提出的“3800亿”有点低估了,有意加码资本开支。年初,阿里巴巴一改以往的谨慎叙事,相信AI爆发远超预期,振奋了国内市场,腾讯也紧随其后宣布加大资本开支。最近四个季度,阿里巴巴已经投入了约1200亿元;下半年,海外市场AI基建进一步加速,让阿里巴巴“10年10倍”的全球算力部署计划略显保守。

对于巨头而言,加码资本开支的关键,并不在于资金,而是AI相关算力硬件。在美国,通过全栈自研摆脱英伟达的CUDA生态,意味着更低的总拥有成本(TCO)与更高效的推理效率。对于中国而言,全栈自研还额外赋予了更自主的AI技术栈、更安全的供应链与更可控的业务预期的意义。

谷歌之所以能在叙事上目前压过英伟达,核心是自研芯片TPU,已经迭代至第七代。黄仁勋辩称英伟达GPU性能领先一代固然没错,但是,它接近75%的利润率意味着,即使客户的自研芯片整体性能略逊,在单位算力成本上也足够打平甚至取胜。谷歌用自己的TPU训练出世界上最领先的前沿大模型,被市场视为英伟达估值逻辑的分水岭。Meta忍不住想要采购谷歌TPU,传言首份订单数十亿美元。由于模型与基础设施的协同优势,随着Gemini在企业端被更广泛采用,外界对TPU和谷歌云的需求只会进一步强化。

最近几个月,英伟达在中国的市场一时清零,或多或少影响了国内互联网平台的AI基建进度。腾讯就陷入了算力“紧平衡”状态。尽管与谷歌仍存在不小的差距,但是阿里巴巴同样很早开始就从计算、网络、存储三个维度,全面重构AI云基础设施。央视意外曝光的阿里巴巴的PPU,参数性能足够可用。它的磐久服务器,目前支持单柜128个GPU,下一步就是512颗AI芯片。

谷歌主导AI叙事的另一个逻辑在于,一旦AI成熟,最终价值会更多地流向应用。阿里巴巴正在补齐自己面向消费者的超级应用的短板。近期,在稳住大消费基本盘的同时,阿里巴巴千问App正式开启公测,首周增量下载就突破1000万。阿里高管将其称为公司同时致力于企业AI和消费者AI的开端。在电话会议上,阿里确认,将逐步在千问App上整合电商、地图导航、本地服务等,将其打造成日常生活的AI入口。这将比OpenAI的购物研究(Shopping Research)更为垂直与闭环。

全栈式AI不仅是一条技术路线,也是一条商业路线。谷歌验证了它可行,阿里正向谷歌“看齐”,并不受市场喧嚣的影响,坚定快跑。