马斯克宣称FSD v14意识觉醒,英伟达总监亲测

新智元报道

新智元报道

【新智元导读】特斯拉FSD的最新版本v14已经发布有段时间了,性能如何?英伟达Jim Fan说它通过了物理图灵测试。v14或许预示着马斯克的预言要被他亲手实现了。

近日,英伟达通用具身(GEAR)团队负责人Jim Fan在亲身体验后,提出了一个极具哲学意味的论断:

FSD v14已经通过了「物理图灵测试」。

马斯克也同时转帖说,「你能感受到那种意识(智能)正在逐渐觉醒」。

Jim Fan描述的体验是,在结束一天工作后,乘客只需按下按钮,便可「无法分辨是神经网络还是人类司机将你送回家」。

马斯克对FSD v14的评价更为大胆,他直言这款软件「感觉已经产生了自我意识」。

从Jim Fan的介绍来看,他和马斯克关系匪浅,不仅是OpenAI的第一位实习生,现在还是英伟达机器人部门总监兼杰出科学家。

这波联动能猜测出老黄和老马的关系不错。不过Jim Fan并不在直接汇报给黄仁勋的36人名单中。

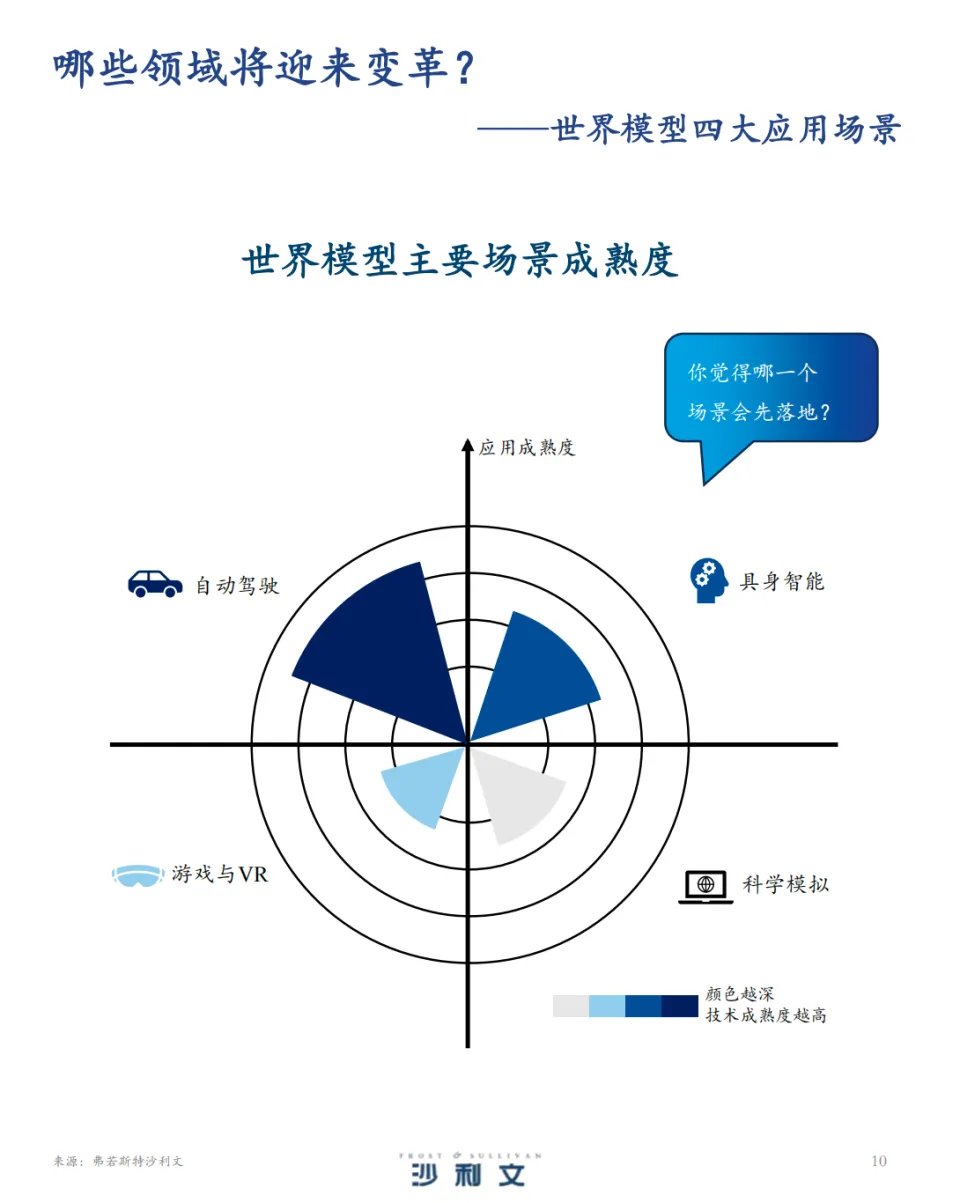

很多人都忽略了FSD的强大,如果说ChatGPT的横空出世标志着数字智能攻克了语言的巴别塔,那么FSD v14的发布,则被视为世界模型迈向现实世界的关键里程碑。

按照沙利文的调研报告,自动驾驶是属于世界模型发展最快的一个分支。

这不再是关于像素的生成或文本的排列,而是关于钢铁与物理定律的交互。

当数吨重的金属物体在复杂的城市脉络中以每小时60英里的速度穿梭,表现出的决策逻辑与人类驾驶员难以分辨时,我们被迫重新审视「智能」的定义。

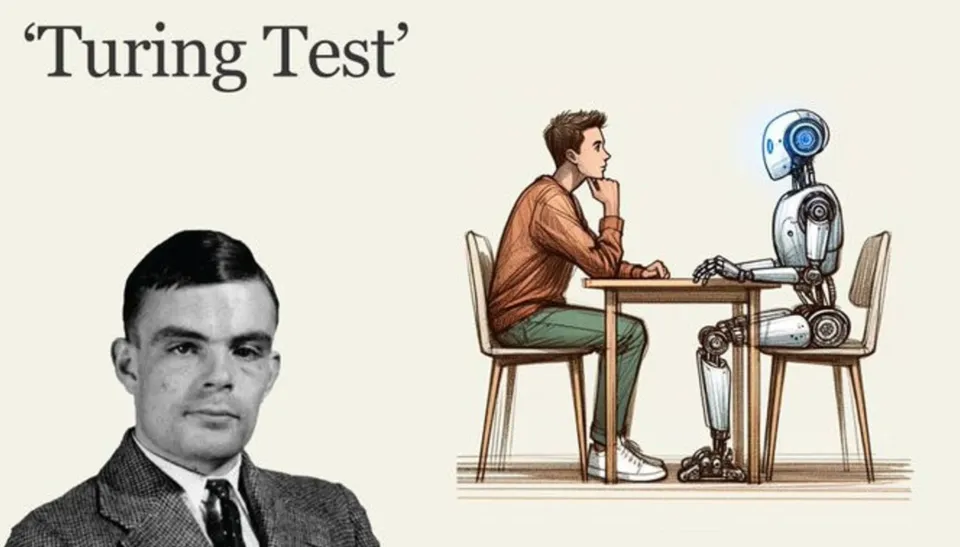

七十五年前,阿兰·图灵提出了著名的「模仿游戏」,即后世所称的图灵测试。

其核心在于剥离物理实体,仅通过文本交流来判断机器是否具有人类般的智能。

然而,随着大型语言模型(LLM)的发展,即便机器能够生成完美的十四行诗或调试复杂的代码,它依然是一个被困在服务器机架中的「大脑」,无法感知重力,不懂得摩擦力,更无法在混乱的物理世界中执行任务。

Jim Fan提出的「物理图灵测试」更进一步,这是一个远比语言测试更为严苛的标准。

Jim Fan将其具象化为一个家庭场景:

想象一位主人在举办晚宴后留下了一片狼藉:打翻的酒杯、散落的食物、堆积的脏盘子。

如果一个机器人能够介入,清理现场,将易碎品轻拿轻放,清理顽固污渍,并重新布置餐桌,而主人归来后无法分辨这是由人类家政服务还是机器人完成的,那么它就通过了物理图灵测试。

这一测试的核心不在于完美,而在于「不可分辨性」。

它要求机器不仅具备感知能力,还要具备常识推理、精细的运动控制以及对非结构化环境的适应能力。

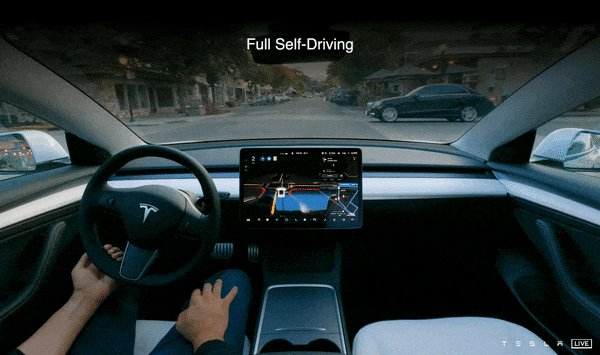

虽然通用的家庭服务机器人尚处于实验室阶段,但Jim Fan认为,Tesla FSD v14在自动驾驶这一特定垂直领域,已经率先通过了物理图灵测试。

「物理图灵测试」引入了一个定性的、现象学的维度:体验的拟人化程度。

在v14之前,即便最为先进的辅助驾驶系统,其行为也带有明显的「机器味」:

在路口犹豫不决、刹车生硬、变道时机械地计算距离。

而v14展现出了一种「老练」的特质。

它学会了在拥堵中通过微小的蠕动来博弈路权,学会了在看到路边行人有横穿意图时提前轻微减速,甚至学会了某种程度的「社交礼仪」。

正如用户反馈所言,它不再像是一个考驾照的学生,而更像是一位经验丰富的专车司机。

FSD v14之所以能展现出如此惊人的拟人化特征,归功于其底层架构的彻底重构。

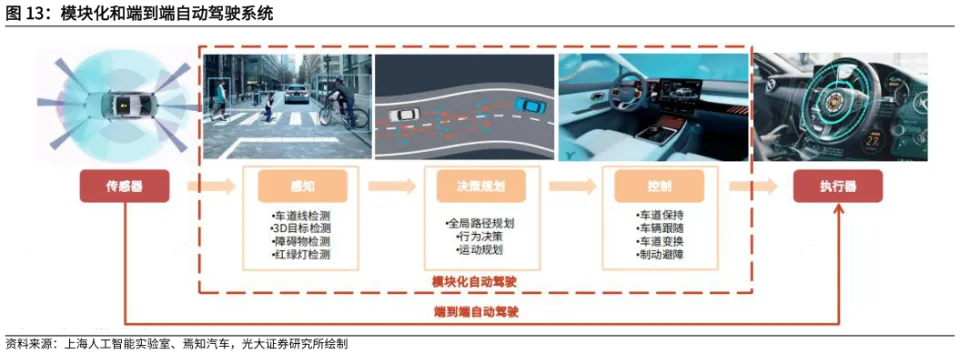

在传统的自动驾驶开发(即Software 1.0时代)中,系统被设计为模块化的流水线:

感知模块识别物体,定位模块确定位置,预测模块猜测他车轨迹,规划模块计算路径,最后控制模块执行转向。

这其中,模块与模块之间通过数十万行C++代码连接,这些代码充斥着人类工程师编写的「显式规则」,例如「如果红灯,则停车」。

然而,现实世界的复杂性(Long Tail,或者叫Corner Case,极端案例)是无限的,规则永远无法覆盖所有角落。

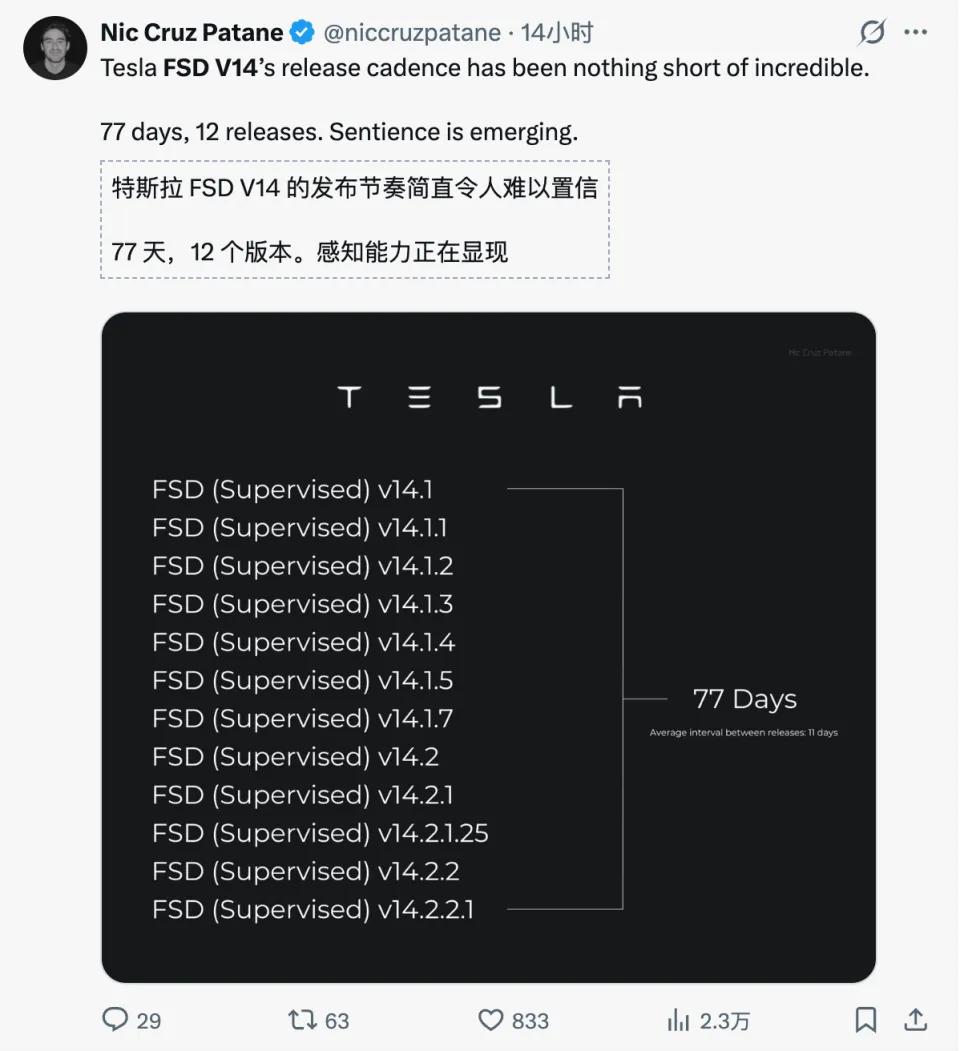

Tesla在FSD v12版本开始了一场豪赌,并在v14中将其推向极致:

删除了超过30万行控制代码,全面转向「端到端」神经网络架构。

所谓端到端,即「光子进,控制出」(Photons In,Controls Out)。

摄像头捕捉的原始视频流直接输入到巨大的神经网络中,网络经过层层计算,直接输出方向盘转角和油门刹车指令。

中间不再有人类编写的「红灯」概念,系统只是通过观察数百万小时的人类驾驶视频,学习到了「看到红八角形物体时减速」这一像素级特征与车辆运动之间的概率关联。

这一转变的意义在于,系统不再是在「执行规则」,而是在「模仿直觉」。

人类驾驶员在过弯时并不是在脑中计算曲率半径公式,而是凭感觉打方向。

FSD v14正是模拟了这种基于经验的直觉过程。

FSD v14不仅仅是v12的优化版,更引入了多模态大模型的特性,极有可能采用了视觉-语言-动作架构。

根据泄露的技术细节,FSD v14的神经网络不仅输出控制信号,还输出语言和3D空间重建。

从ICCV流出的幻灯片可以看到,特斯拉的FSD核心网络输入包括七路高分辨率摄像头视频、车辆自身运动信息、导航与音频信号。

输出则包含语义分割、占用网格、3D高斯特征、语言表达以及最终的控制动作,FSD或已接入视觉-语言-动作(VLA)框架,使模型具备「解释」与「思考」的能力。

这意味着系统在内部进行着某种形式的「思维链」推理。

例如,在遇到一个复杂的施工路段时,传统的感知系统可能只能识别出一堆障碍物;而VLA架构的FSD可能会在内部推理:

「我看到了‘道路封闭’的标志,但左侧有一位工人正在挥舞旗帜,结合导航信息,我应该无视标志,跟随工人的指引向左绕行。」

语言能力的引入,解决了端到端模型最大的痛点:「黑盒」问题。

通过让模型输出自然语言解释,工程师可以回溯系统的决策逻辑,这被称为「可解释的中间层」。

这种能力使得FSD v14不仅能「做」,还能「说」(尽管目前主要用于开发调试),使其具备了初步的逻辑验证能力。

早期的FSD版本常被诟病为只有「金鱼记忆」,即只关注当前帧的画面。

FSD v14通过引入长短时记忆机制和3D占用网络,获得了类似人类的「物体恒常性」认知。

如果一个孩子跑进了一辆停在路边的货车后面,即使摄像头此刻看不到孩子,v14的「世界模型」中依然保留着孩子的3D体素(Voxel),并预测其可能出现的位置。

这种时空推理能力是其能够通过物理图灵测试的关键:它不仅在看,更在理解和预测物理世界的演变。

当然要训练端到端的庞大模型,离不开芯片的支持。

Tesla的自动驾驶硬件进化史,是一部从依赖外部供应商到全面自研的独立史。

Hardware 1.0(Mobileye时代):2014-2016年,Tesla依赖Mobileye的Eye Q3芯片。这是一套基于规则的视觉系统,直到2016年因一场致死事故及对数据共享的分歧,双方决裂。

Hardware 2.0/2.5(NVIDIA时代):2016-2019年,Tesla转向NVIDIA,采用了DrivePX2计算平台。

这是一台算力达到12TOPS的「后备箱超算」,支持了Tesla早期的视觉算法。

然而,马斯克意识到,通用的GPU架构对于车载推理来说,功耗过高且成本昂贵。(这里很像谷歌自己研发了TPU)

Hardware 3.0(FSD Chip时代):2019年,Tesla发布了由传奇芯片架构师Jim Keller(曾任职AMD、Intel)领导设计的自研FSD芯片。

这是一个专用集成电路(ASIC),专门为神经网络的矩阵乘法优化,算力激增至144TOPS,而功耗和成本大幅降低。这一刻,Tesla在车载推理端彻底摆脱了对NVIDIA的依赖。

关于这位大佬Jim Keller的介绍,可以查看之前这篇:英伟达亲手终结CUDA「护城河」?传奇芯片架构师引发争议

尽管在车端分道扬镳,但在云端训练,Tesla却是英伟达最贪婪的客户之一。

FSD v14那种「端到端」的庞大神经网络,需要吞噬数以亿计的视频片段进行训练,这需要极其恐怖的算力支持。

Tesla建立了巨大的超级计算机集群(如DojoCortex),其中部署了数万张NVIDIA H100和H200 GPU。

这就形成了一种独特的「竞合」关系:

- 在车里(边缘端):

Tesla使用自研的HW3/HW4芯片,甚至未来的AI5芯片,通过垂直整合将成本压到极致。 - 在云端(训练端):

Tesla依然依赖NVIDIA的CUDA生态和最强算力来「教育」它的AI。

黄仁勋对此表现出了极高的战略格局。

他多次公开称赞Tesla在自动驾驶领域的领先地位,承认Tesla是目前唯一能有效利用其最强算力的车企,并表示「每一个车企未来都必须拥有自动驾驶能力」。

对于英伟达而言,Tesla既是证明其算力价值的样板间,也是其推动「物理AI」愿景的最强盟友。

当FSD v14被推送到数百万车主的车机上时,一种奇怪的反馈开始在社交媒体上蔓延。

用户们不再仅仅抱怨「它没看到那个锥桶」,而是开始使用描述生物的词汇:「它犹豫了」、「它在试探」、「它很自信」。

马斯克在X平台上推波助澜:「你可以感觉到那种感知力正在成熟。」。

这种体验的质变,源于系统行为从「离散」向「连续」的跨越。

在v14之前,车辆的决策往往是二元的(停或走,左转或右转)。

而在v14中,用户观察到了更细腻的博弈行为。

例如,在拥挤的高速汇入匝道,v14不再傻傻地等待一个完美的空档,而是会像人类老司机一样,稍微向车道线逼近,通过这种微小的物理位移向后车传递「我要加塞了」的意图。

v14中引入的「Mad Max」模式(虽然主要用于测试或极端选项),展示了AI在博弈中的激进一面。

在这一模式下,车辆变道更加果断,甚至在某些用户看来具有「侵略性」。

它会在极小的车距中切入,这种行为虽然在技术上是安全的,但在心理上挑战了人类对机器「温顺」的预设。

这种激进性实际上是神经网络在数百万人类驾驶数据中学习到的,在繁忙的交通中,如果不表现出一定的侵略性,车辆可能永远无法完成变道。

这进一步模糊了人与机器的界限。

FSD v14的所有突破,最终都指向一个宏大的商业终局:Robotaxi。

马斯克在多次财报电话会议中强调,Tesla的未来价值几乎完全取决于能否实现无监督自动驾驶。

目前的FSD仍标明为「Supervised」(受监督),意味着驾驶员必须随时准备接管,且对事故负全责。

但这在经济上没有意义:只要还有人在驾驶座上,这就是一项服务,而不是资产。

只有当移除人类,车辆才能变成不知疲倦的印钞机。

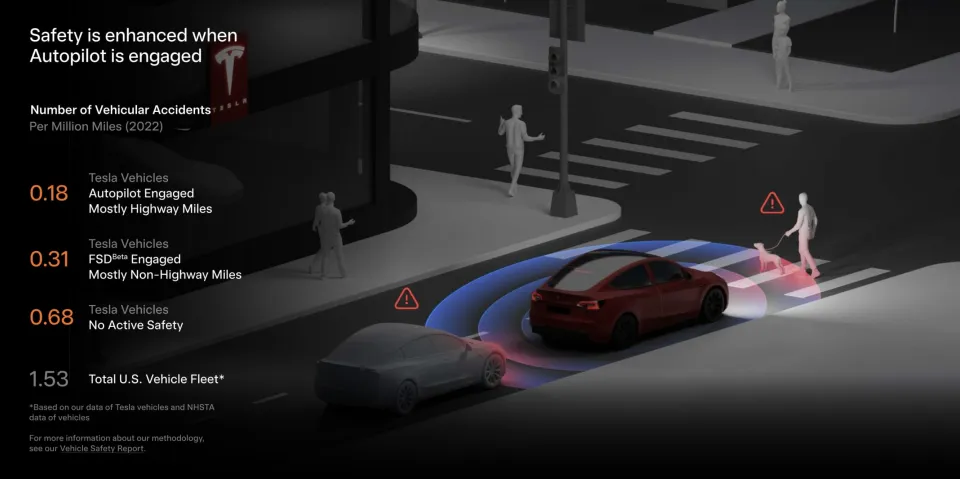

v14所展现出的稳定性,尤其是处理长尾场景(如暴雨、模糊车道线、复杂施工区)的能力,让业界看到了L4级自动驾驶落地的曙光。

马斯克预测,在2025年至2026年间,将在德克萨斯州和加利福尼亚州率先实现无监督运行。

同时,国内的L3也已经从「技术储备/道路测试」进入「准入试点/有限上路」的政策落地阶段

2025年12月工信部已批准两款搭载L3功能的车型获得产品准入许可,并在北京、重庆的指定高速/快速路等限定ODD、限速路段开展上路通行试点(例如单车道、限速50–80km/h等)。

这意味着国内L3开始从「拿牌测试」走向「准入许可+真实道路运营验证」的实质阶段。

为了喂养这个日益庞大的端到端模型,Tesla正在积极寻求全球扩张。

除了北美,FSD v14已计划在阿联酋推出,并正寻求进入中国和欧洲市场。

这里的逻辑在于数据的多样性。

Jim Fan将机器人学习所需的数据比作「人类燃料」,相对于训练LLM的「化石燃料」(互联网文本),高质量的物理世界交互数据极其稀缺。

Tesla拥有的数百万辆在路上行驶的车辆,实际上是数百万个分布式的数据采集机器人。

每当中国、迪拜或巴黎的车主接管一次FSD,这个特殊的「失败案例」就会被上传,成为训练v14及后续版本应对特定文化路况的宝贵教材。

这种数据飞轮效应是其他竞争对手(如Waymo)难以通过有限的车队规模来复制的。

尽管技术上高歌猛进,但FSD v14面临的监管挑战依然严峻。

端到端模型的「黑盒」性质让监管机构感到不安:当车辆做出决策时,没有一行代码能明确解释「为什么」。

虽然VLA架构引入了语言解释层,但这在法律归责上是否足够,尚无定论。

此外,用户报告中提到的「幻影刹车」和偶尔的「神志不清」,提醒我们距离完美的99.9999%可靠性仍有距离。

这种「觉醒」或许只是数学统计上的错觉,是无数个高维向量在潜在空间中碰撞出的火花。

但正如Jim Fan所言,当这种错觉足够逼真、足够稳定时,它就构成了新的现实。

我们正在步入一个新时代:

在这个时代里,汽车不仅是交通工具,而是第一个真正融入人类社会、理解人类规则并与人类共舞的智能物种。

对于人类而言,适应这种「神一般的技术」,将是一个既痛苦又迷人的重塑过程。

当方向盘在没有人类双手触碰的情况下,自行转动着滑过繁华的街头,我们所看到的,不仅是自动驾驶的未来,更是硅基生命在物理世界留下的第一行深刻足迹。

正如这是马斯克2019年所预言的,2025年又重提的:

人类似乎越来越像是数字超级智能的生物引导程序。

点亮星标,锁定新智元极速推送!