千星项目LLMRouter:多模型路由,16+策略优化推理

新智元报道

新智元报道

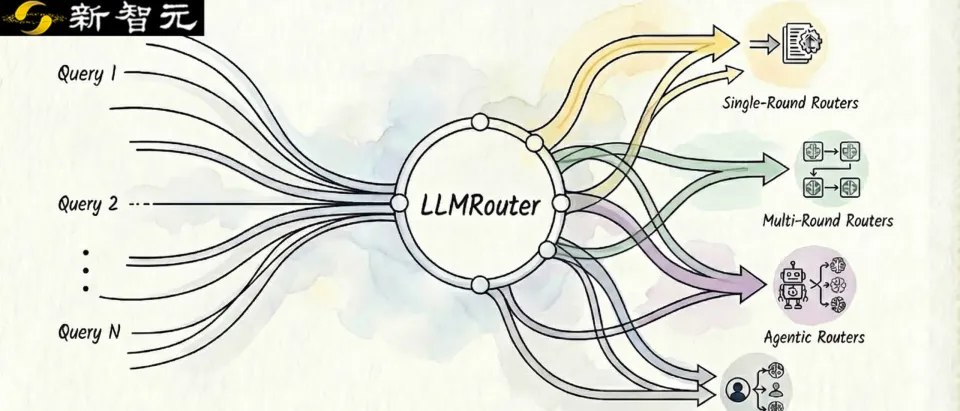

【新智元导读】UIUC开源的智能模型路由框架LLMRouter可以自动为大模型应用选择最优模型,提供16+路由策略,覆盖单轮选择、多轮协作、个性化偏好和Agent式流程,在性能、成本与延迟间灵活权衡。

当可选大模型越来越多,「用哪个模型回答这个问题」本身正在变成新一层系统能力:简单请求用小模型快速低成本完成,复杂请求再交给强模型深度推理;必要时还可以多轮试探、分配预算、甚至多模型协同聚合结果。

把这种面向每个query的模型选择与调度做成稳定、可复现、可扩展的工程化组件,就是LLM Routing的意义所在。

LLMRouter正是为此而来:它把路由器的训练、评测、推理与交互链路统一起来,并提供16+路由策略与一致的CLI数据流水线,让研究者能公平对比方法,让工程团队能快速落地「更聪明、更省钱」的多模型推理系统。

近日,来自UIUC Ulab的研究团队正式开源LLMRouter:一个面向研究与落地的LLM Routing统一框架,把「训练/评测/推理/交互/扩展」打通,让你不用再从零实现一套模型路由系统。

代码链接: https://github.com/ulab-uiuc/LLMRouter

文档链接: https://ulab-uiuc.github.io/LLMRouter/

发布不到半个月,截至目前,GitHub仓库已经突破1K Star并在持续增长中,展现出了社区的广泛关注度,这也从侧面印证了一个趋势:当候选模型越来越多、成本与时延约束越来越强,「模型路由与调度层」正在从锦上添花变成基础设施。LLMRoute希望把这件事做成可复用、可对比、可扩展的标准化框架,让研究与工程都能更快落地与迭代。

LLMRouter是一个「智能模型路由系统」,目标是:对每个用户query动态选择最合适的模型,在性能/成本/延迟之间做可控权衡。它在框架层面提供了四块「开箱即用」的能力:

Smart Routing:基于任务复杂度、成本、性能需求自动分配到最优LLM

16+ Router Models:覆盖单轮 / 多轮 / Agentic / 个性化四大类模型路由方法(KNN、SVM、MLP、MF、Elo、Graph-based、BERT-based、混合概率、transformed-score 等)

统一CLI + Gradio交互:训练、推理、对话一套命令搞定

数据生成流水线:支持从11个 benchmark 数据集,多模态数据集自动生成训练数据与评测

在正式开源LLMRouter之前,团队对当前主流的LLM Router研究与工程实践进行了系统梳理:从传统的分类/回归式路由器、基于打分或对比学习的策略,到更复杂的多轮路由、个性化路由、以及agentic routing。

尽管这些方法在形式与实现细节上差异显著,但在对比其核心流程后可以发现:绝大多数Router都能够抽象拆解为两个相对独立、却又可以灵活组合的关键子模块:Route与Training。

Route模块解决的是「如何路由」的问题:它专注于在推理阶段根据输入数据读取 Router Backbone 的输出,并执行route操作——例如选择调用哪一个候选模型、是否进入多轮、是否进行结果聚合,以及在多模型间如何分配预算与计算资源。

换言之,Route模块承担「从模型输出到可执行路由动作」的决策职责,天然对应inference-time的决策层。

Training模块解决的是「如何学会路由」的问题:它负责对Router Backbone施加具体的训练逻辑与优化过程——包括数据构建、监督学习目标、偏好/排序损失、bandit化学习式优化、多轮credit assignment、以及离线评测与在线反馈闭环等。Training模块更偏向learning-time的优化层,决定了Router如何从数据与反馈中持续迭代提升。

基于这一观察,LLMRouter 在框架层做出了关键的架构选择:将Route与Training明确解耦,形成可插拔、可重用、可组合的系统设计。 这种解耦带来三点直接价值:

领域统一:不同论文/系统提出的Router不再是相互割裂的工程实现,而可以被对齐到统一抽象下进行公平比较——同一Route逻辑可搭配不同Training 方案,同一 Training 方案也可迁移到不同 Route 机制之上。

开发友好:开发者可以更聚焦地创新:要么提出新的路由决策机制(Route),要么提出新的学习与优化方法(Training),而无需每次从零重写完整系统。

高扩展与易复现:模块边界清晰使得新增或复现 Router 更像「搭积木」:选择 backbone + route 规则 + training 配方,即可快速落地新方法,并在统一流水线下完成训练与评测。

通过这种「Route × Training」的架构,LLMRouter 试图将 LLM Routing 从「实现碎片化」推进到「组件化与体系化」:让路由策略更容易复用、对比更公平、扩展更高效,也让开发者能够基于同一套框架更灵活地设计与验证自己的 Router 方法。

LLMRouter 将路由策略按能力形态做了清晰分层:

Single-Round Routers:一次决策把 query 路由给最合适的候选模型(例如 knnrouter / svmrouter / mlprouter / mfrouter / elorouter / graphrouter / ...)

Multi-Round Routers:面向复杂任务的多轮路由(例如内置了 router_r1 的推理式多轮路由能力)

Personalized Routers:把用户偏好纳入路由决策(例如 gmtrouter)

Agentic Routers:为复杂问题提供「更像 Agent 的路由流程」(例如 knnmultiroundrouter / llmmultiroundrouter)

LLMRouter的设计目标之一是开箱即用。通过以下简洁三步,即可在3分钟内启动你的第一个模型路由器:

安装 (Installation)

推荐使用 PyPI 进行安装,简单快捷:

python -m pip install -U pippython -m pip install llmrouter-lib

配置 API Keys (Setup)

LLMRouter 在推理时通过 LiteLLM 调用兼容 OpenAI 接口的后端模型,因此需要配置 API_KEYS 环境变量。

快速配置示例(将 YOUR_KEY 替换为你的实际密钥):

export API_KEYS="YOUR_KEY"支持多服务商与多 Key 轮询:我们支持配置复杂的 JSON 列表或服务商字典,实现多模型、多 Key 灵活调度。更详细的配置方式,请参考官方文档。

运行与交互 (Run & Chat)

使用统一的 CLI 命令行工具,即可一键列出所有可用路由器,并启动 Gradio 交互界面:

llmrouter list-routersllmrouter chat

Chat模式内置支持多种对话机制(例如:只看当前 Query、拼接完整对话或检索历史 Top-K),以满足不同场景下的测试需求。

研究者/工程师最关心的:可扩展吗?能「插拔」新路由吗?

答案是可以。

LLMRouter内置了plugin system:你可以把自定义router放在custom_routers/下,不改动核心代码即可接入,训练/推理/对话仍然走统一CLI

最短路径是四步:建目录 → 写一个继承MetaRouter的router → 配置YAML → 直接llmrouter infer调用。

这意味着你可以快速验证新的路由策略(比如你自己的reward shaping、bandit、graph 路由、偏好建模等),并且和现有16+ router在同一套CLI/数据管线下做可复现实验对比。

自项目在2025 年12月底正式发布以来,GitHub Star数已突破1K+并在持续快速增长中。

过去,选模型更多靠经验:简单问题丢给小模型,复杂问题交给大模型。听起来合理,但「简单/复杂」怎么定义?成本、延迟、质量怎么权衡?不同用户偏好是否一致?这些判断往往模糊、难复现,也就更难迭代。

LLMRouter 想做的,是把这种「拍脑袋的选择」变成一个可复用、可对比、可扩展的系统化能力:

16+ 路由策略:覆盖经典机器学习、图方法、打分融合,以及单轮/多轮/agentic/个性化四大类主流路线

个性化路由:把用户偏好纳入决策,真正做到「同题不同人,不同模型」

统一工程化框架:训练、评测、推理、交互到扩展,一套 CLI 跑通,并配套 11 个基准的数据生成流水线

插件式扩展:自定义 router / task / metric 能无缝接入同一套流程,方便复现与公平对比

在这个框架里,Router 不再只是「分发器」,而更像一个多智能体协调者:决定该由谁来答、是否进入多轮、是否需要混合/聚合,复杂问题通过「多模型分工 + 协作」更稳,简单问题快速分流到轻量模型,把不必要的昂贵调用压下去。

更重要的是,这个趋势已经被业界的「统一系统」路线验证:OpenAI 在 GPT-5 的系统卡与产品说明里明确提到,它是由快速模型、深度推理模型以及实时路由器组成的统一系统,路由器会根据上下文在不同能力路径间动态选择。

这也印证了我们想推动的方向:多模型协同路由,会成为未来大模型应用不可或缺的基础设施层。未来的 LLM 应用不是单一模型的独角戏,而是多模型协同的交响乐——Router,就是那个指挥。