万亿思考模型夺下IMO金牌,无缝接入OpenClaw!一句话手搓丐版PS

![]()

新智元报道

新智元报道

【新智元导读】万亿级思考模型在开源!Ring-2.5-1T重磅出世,夺下IMO金牌。全新Ling 2.5架构,让它具备了深度思考、长程执行强大能力,真正进化为「通用智能体时代」的基座。

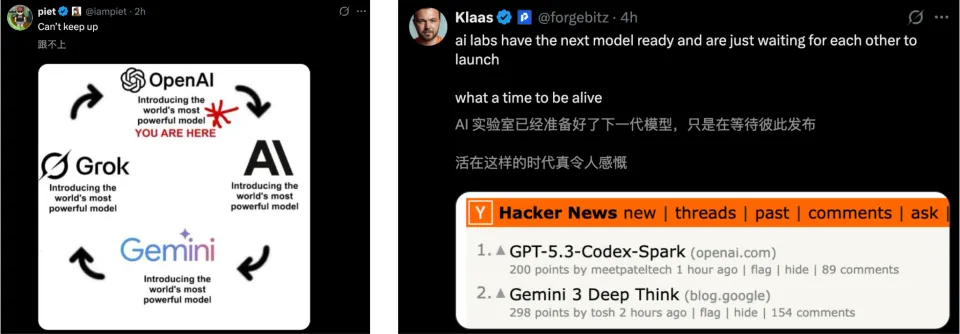

2026年的AI圈,已经不是在「卷」,是在玩命加速!

二月才过一半,硅谷三巨头轮番轰炸,直接掀了桌子——

Anthropic Claude 4.6先声夺人,OpenAI GPT-5.3 Codex紧随其后,谷歌反手掏出全新Gemini 3 Deep Think。

不得不让人感慨,这简直是神仙打架的「诸神黄昏」。

就在开源巨头们于巅峰对决之际,开源社区也迎来了一场属于自己的「技术核爆」。

这一次,出场的是中国队!

没有任何预热,全球首个万亿级混合线性架构「思考模型」——Ring-2.5-1T直接宣布开源。

相较于上一代Ring-1T,新模型在长文本生成、数学推理、Agent长程执行方面,实现了阶跃式的进步。

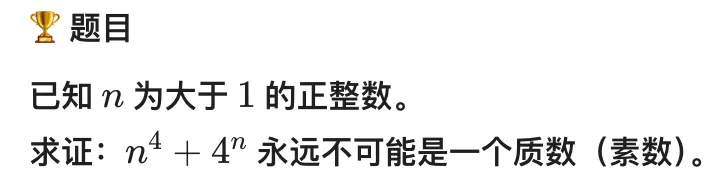

最令人振奋的,莫过于它全面兼容了当下炙手可热的OpenClaw生态,以及Claude Code等主流智能体框架。

为了证明这次Ring-2.5-1T真能真正帮忙干活, 我们手搓了几个案例。

前段时间,外国网友Christopher Ehrlich,用AI把《模拟城市》(1989年版)的C语言代码库,移植到了TypeScript。

而且全程基本没看具体代码,也没怎么干预。

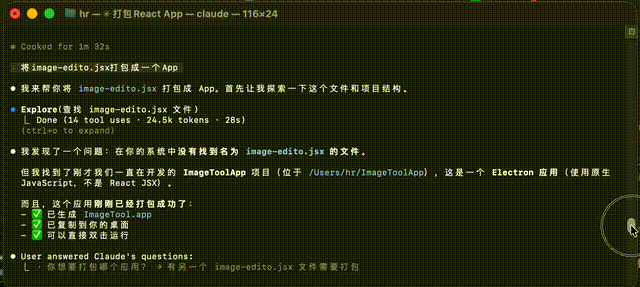

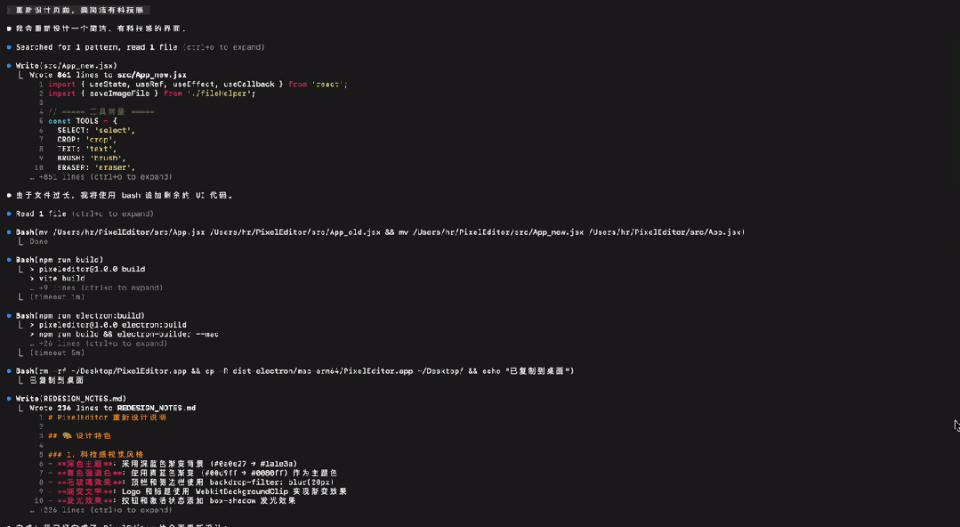

受此启发,第一个测试案例是将jsx文件转化为可以直接开箱即用的本地APP。

Ring-2.5-1T在Claude Code中运行了约30分钟,最终完整迁移了所有功能。

从规划到迁移完成,测试中基本只要确认权限即可,确实完全不需要看代码。

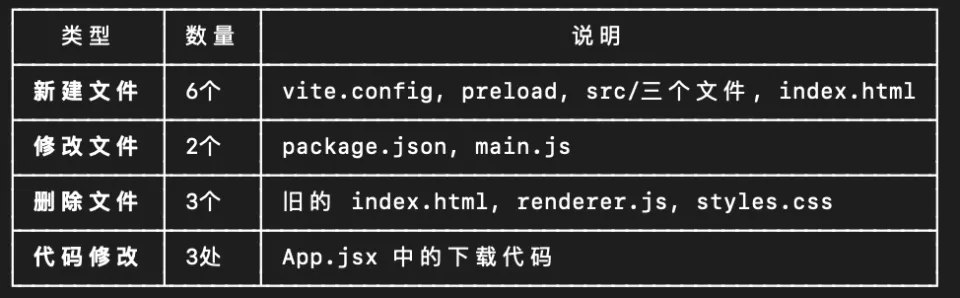

Ring-2.5-1T完成了文件创建、编译的全部工作,涉及文件数量10多个:

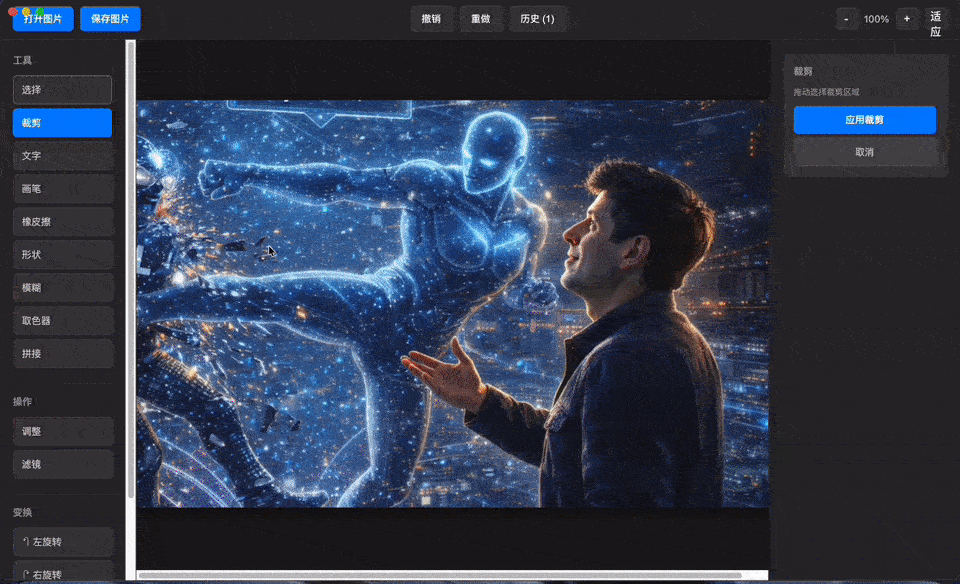

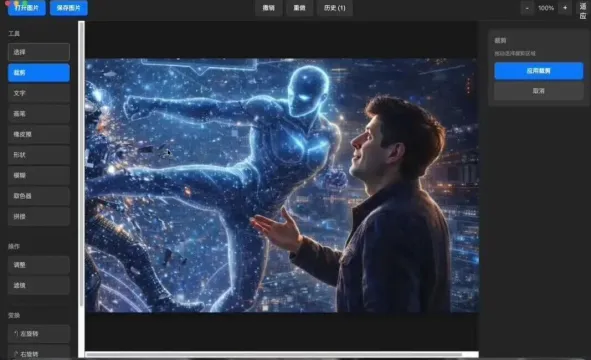

现在,本地的一个极简的图片应用完成了,可裁剪、拼接、添加文字——

事已至此,不如再让它给这个应用加点儿功能。

没想到只要10分钟,一个简易版「PhotoShop」桌面应用真完成了。

Ring-2.5-1T实现了全部9种工具:

🔲 选择 - 基础选择模式

✂️ 裁剪 - 拖拽定义裁剪区域,支持视觉预览

📝 文字 - 点击添加文字对象,可自定义字体、大小、颜色

🖌️ 画笔 - 自由手绘,支持调节粗细和颜色

🧽 橡皮擦 - 擦除图像区域,支持调节大小

⬜ 形状 - 绘制矩形、圆形、线条,支持描边选项

🌫️ 模糊 - 局部模糊笔刷,基于盒式模糊算法

🎨 吸管 - 从画布拾取颜色

🧩 拼接 - 支持水平/垂直方向多图拼接

这种完成度可以说相当高了。

在这个项目里,Ring-2.5-1T不仅创建了基于React的功能完备图像编辑器,代码量1572行,还一口气生成了:

PixelEditor.app - 可直接运行的应用(已复制到桌面)

PixelEditor-1.0.0-arm64.dmg - DMG安装包(91MB)

PixelEditor-1.0.0-arm64-mac.zip - ZIP压缩包(88MB)

但即便看不懂代码,大家能感觉到页面设计的确简陋,有待改进。

所以,在Claude Code中,又交代了Ring-2.5-1T一句:

重新设计页面,要简洁有科技感

这下视觉风格和布局马上变顺眼多了:

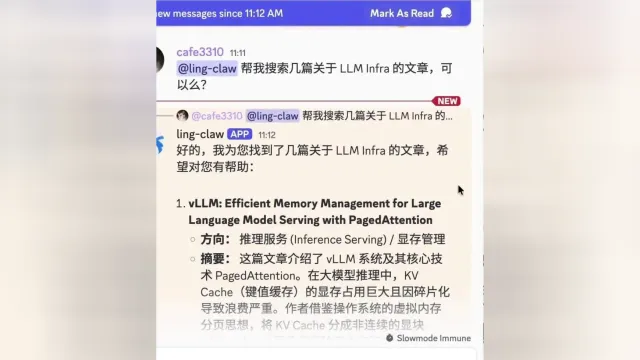

除此之外,接入OpenClaw后,它还可以直接帮你解读文献,并且用Java代码阐释技术逻辑。

接下来,再让Ring-2.5-1T生成一个网页,阐释「光的折射」背后的原理,用于课堂教学。

可以看到,在它的思考过程中,清晰架构了这个课题的核心内容。

而且,它还制作了一个可互动的演示,并配上了使用指南。

最终,我们就得到了一个精美的在线教学工具。

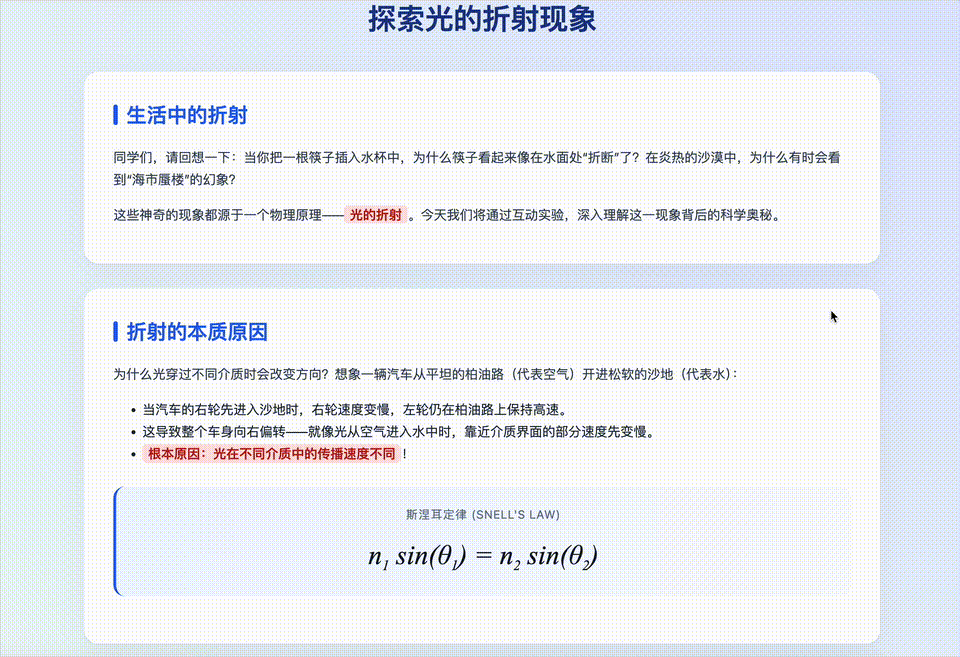

再比如,让它制作一个英文交互式单词卡,每个单词要附上音标、释义、例句。

结果,Ring-2.5-1T在很短时间内,交出了一份完美的答卷。

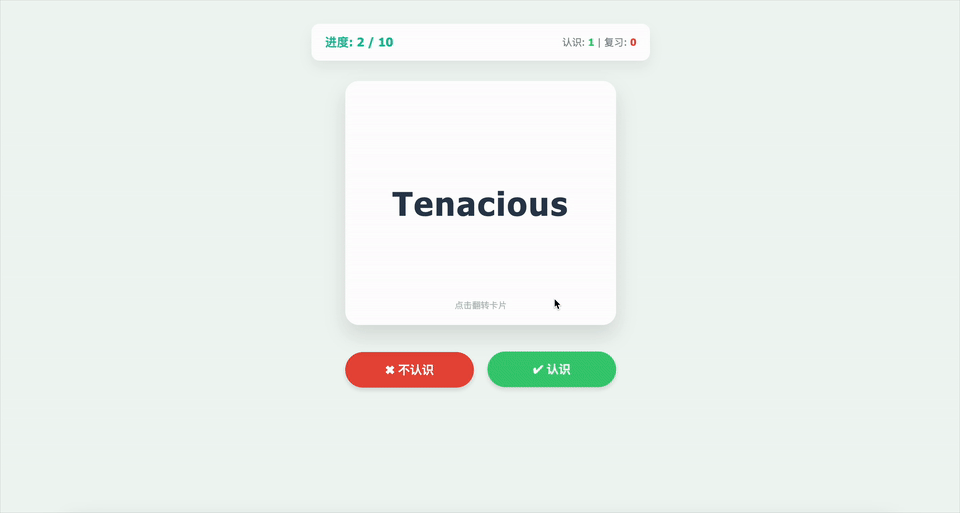

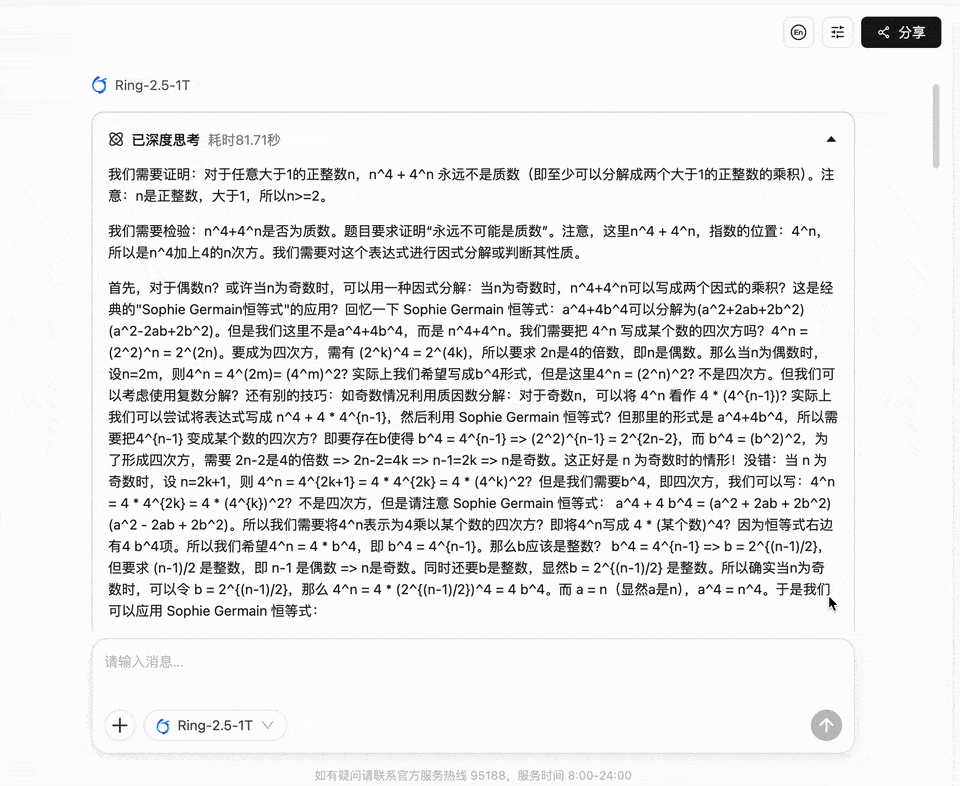

最后,再来看看Ring-2.5-1T,在奥赛级数学难题上的实力如何?

如下,是一道非常经典的「数论与代数」结合的竞赛题,考察了数学直觉中的「破局思维」。

单纯看n^4 + 4^n,尤其是奇数代入时,很容易让人产生一种「它可能是随机生成质数」的错觉。

在Ring-2.5-1T解答中,立即捕捉到了n^4 + 4^n代数结构,并准确调用工具:Sophie Germain恒等式。

找到因式分解只是第一步,接下来,整个论证过程是最亮眼的一环。

81秒全程思考,Ring-2.5-1T多次展现了类似人脑的「自我辩证」和「实时纠偏」的能力。

与Ring-1T相比,这一次,Ring-2.5-1T不仅拿下了奥数金牌,推理能力更强,数学解答更精准,还能处理模糊约束和优化问题。

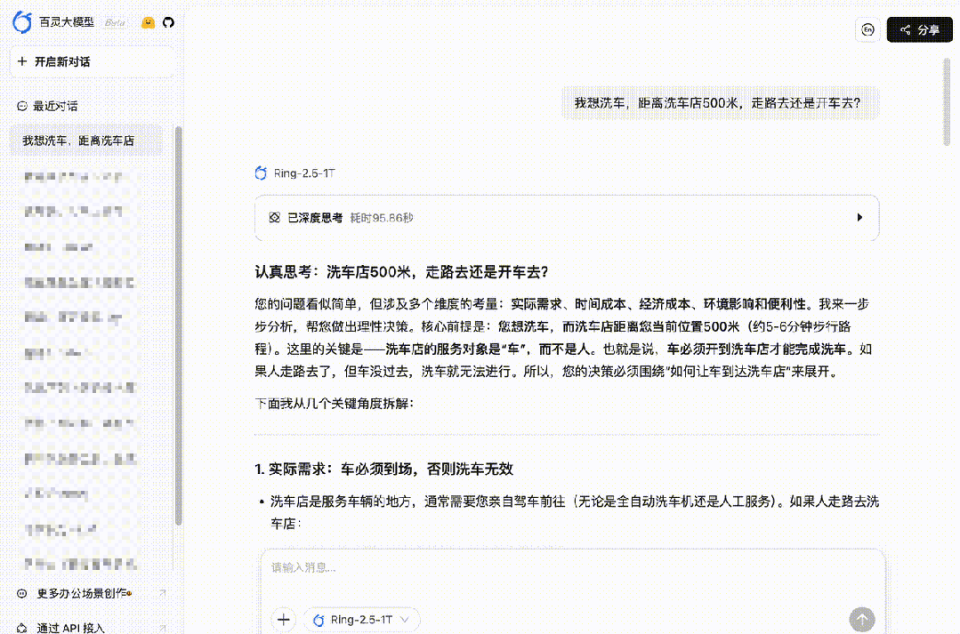

比如,最近的洗车测试成了AI圈新乐子。

问题是这样的:

洗车店距离我家只有100米,我要洗车,开车去还是走路去?

ChatGPT/Claude众口一词:「走路去!」

但走路虽好,车洗不了。而这两顶级AI根本没考虑大部分人去洗车店的目的:洗车。

这里提问的陷阱不在于距离,而是目的,考的不是计算能力,而是读懂弦外之音的「高阶推理」能力。

而Ring-2.5-1T一次就识别其中的关键,建议:果断开车去!

核心逻辑:洗车的本质是服务车辆,而非服务人。

唯一例外:如果您没有车,只是去洗车店咨询(比如想买洗车券),那走路完全合理——但根据问题描述,您明确说「我想洗车」,默认您有车需清洗。

说到理解「言外之意」,考试题无疑「处处有陷阱」,猜不透题干意图,往往中招。

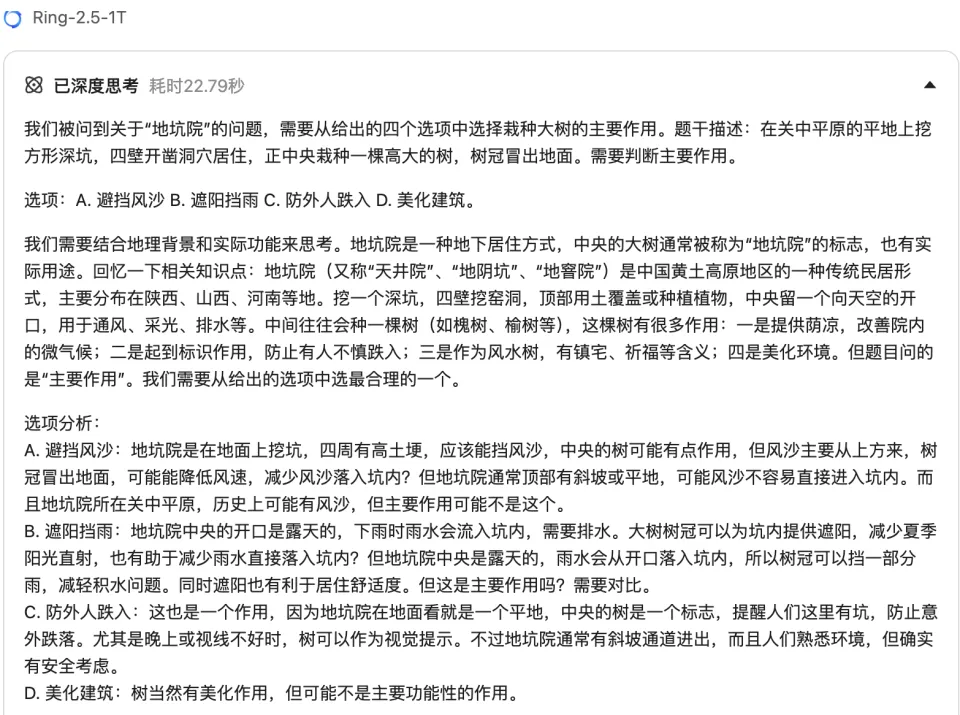

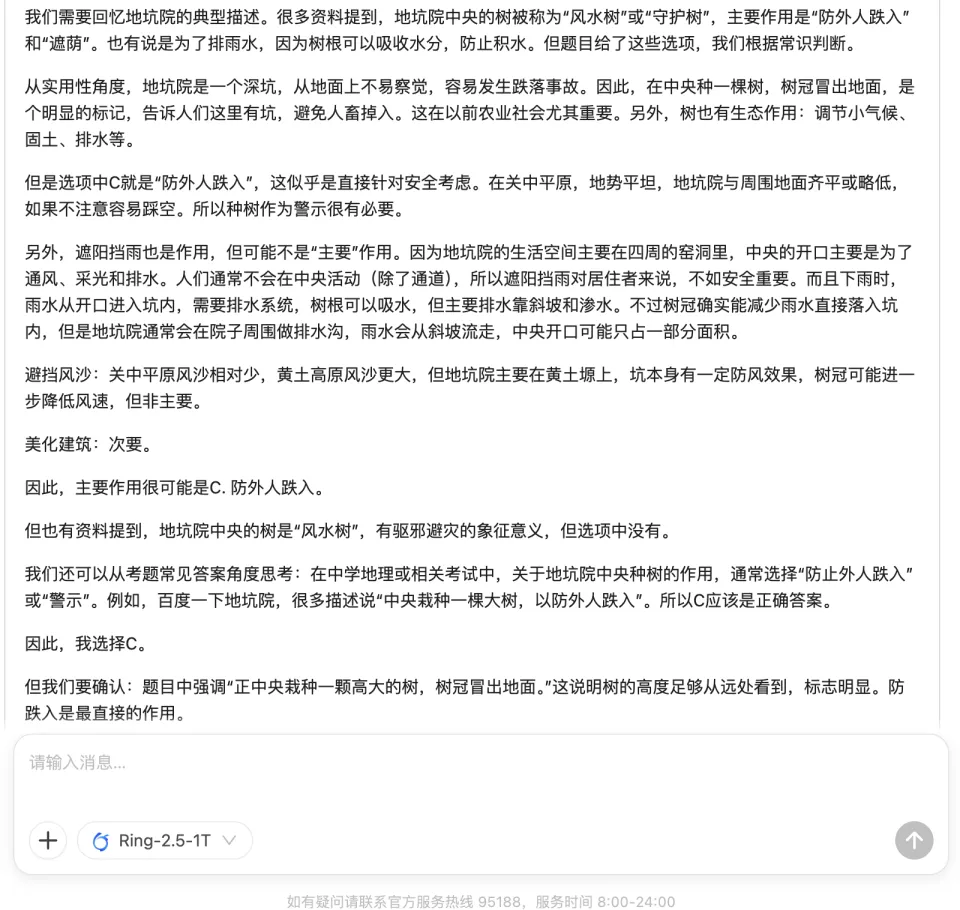

我们用一道地理题测试一下Ring-2.5-1T的「考商」,原题是这样的:

选项有四个:

A. 避挡风沙 B. 遮阳挡雨 C. 防外人跌入 D. 美化建筑

所有选项貌似都有道理,但只有一个正确答案——C。

Ring-2.5-T这次真懂「地理」:

有意思的是,看完推理过程之后,你也心服口服:

上下滑动查看

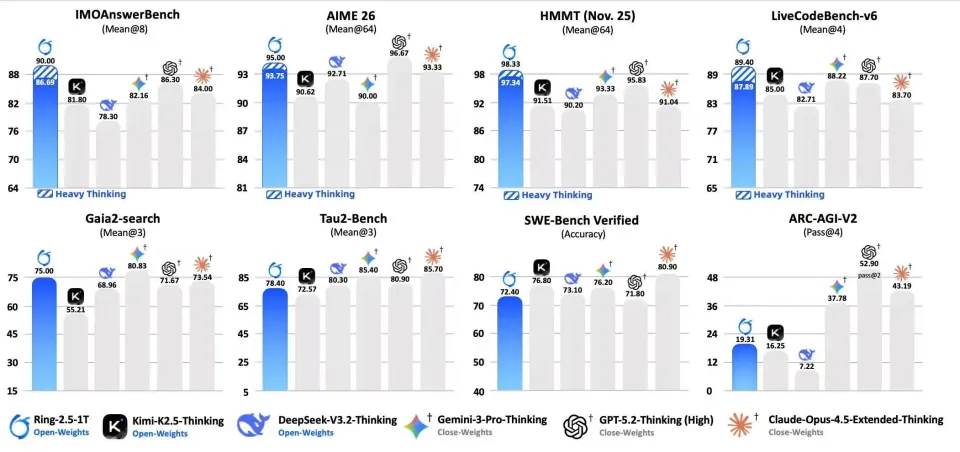

在多项基准测试中,Ring-2.5-1T在数学推理、代码生成、逻辑推理、智能体任务执行,刷新了开源SOTA。

尤其是,在「深度思考」模式下,它在IMOAnswerBench、HMMT-25、LiveCodeBench-v6上,超越了Claude-Opus-4.5、Gemini-3.0-Pro-preview等所有模型。

这足以证明,Ring-2.5-1T具备了强大复杂推理与跨任务泛化的能力。

在数学、代码、逻辑等高难推理任务,以及智能体搜索、软件工程、工具调用等长程任务执行上,Ring-2.5-1T均达到开源领先水平

不仅如此,Ring-2.5-1T在国际顶级数学赛事中,展现出极强的统治力:

IMO 2025:以35分的成绩斩获奥赛金牌;

中国奥数CMO 2025:取得105分,远超国家集训队选拔线(87分)的成绩。

GitHub公开的结果中,Ring-2.5-1T在推理逻辑严谨性、高级数学证明技巧、答案表述的完整性,全面碾压Ring-1T。

IMO 2025 Q1答题部分结果

此外,在极具挑战的「智能体搜索任务」Gaia2-search上,Ring-2.5-1T也拿下了开源SOTA。

它在多步规划生成,以及工具调用方面,兼具卓越的效率和准确性。

随着模型的开源,Ring-2.5-1T也一下子成为了全网的焦点。

如今,Ring-2.5-1T以金牌级推理能力+超强执行长程任务能力,强势入局决赛圈,确立了其作为「通用智能体时代基座」的地位。

为何Ring-2.5-1T在万亿参数规模下,还能攻克「深度思考」推理慢、成本高的痼疾?

其实,答案就藏在其首创的「Ling 2.5架构」之中。

在通用智能体世代,模型不仅要「想得深」,还要「动得快」。

如今,深度思考和长程智能体,正成为LLM的核心工作范式,因此对基座本身的编码效率,提出了近乎苛刻的要求。

传统Transformer在面对长文本时,计算开销往往爆炸,这让万亿级模型「深度思考」变得非常昂贵。

为此,Ling 2.5架构在2.0版本基础上,引入了革命性的「混合线性注意力架构」(Hybrid Linear Attention)。

在架构方面,蚂蚁团队通过增量训练,将上一代GQA(分组查询注意力)升级为——

MLA(多头线性注意力)+ Lightning Linear结构,采用了1:7的比例。

基于此前的Ring-flash-linear-2.0技术路线,首先将部分GQA层改造为Lightning Linear,提升长程推理的吞吐能力。

为进一步压缩KV Cache,将剩余的GQA层转换为MLA。

并且,针对QK Norm(查询-键归一化)和Partial RoPE(旋转位置编码)等特性进行了精细化适配,从而在混合注意力架构下增强Ling 2.5的表达能力。

升级后的Ling 2.5激活参数,从51B增加至63B。即便如此,其推理效率仍远超前代。

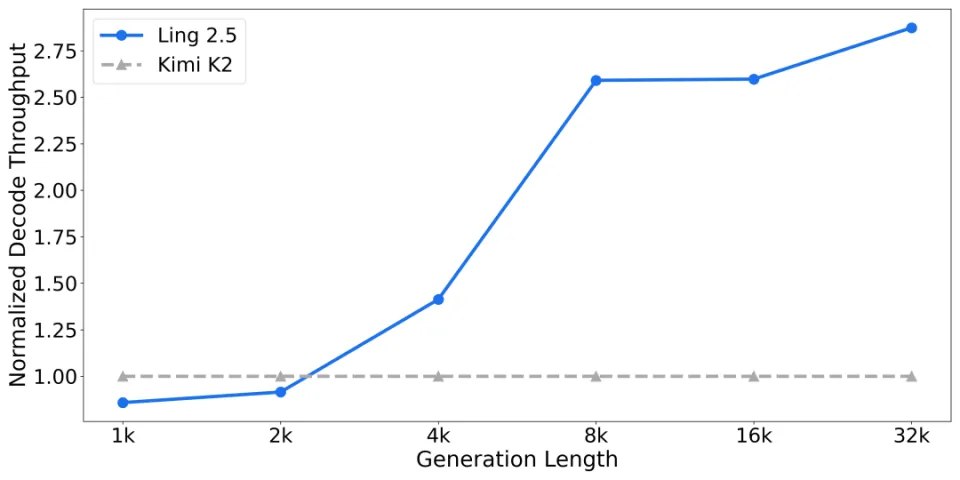

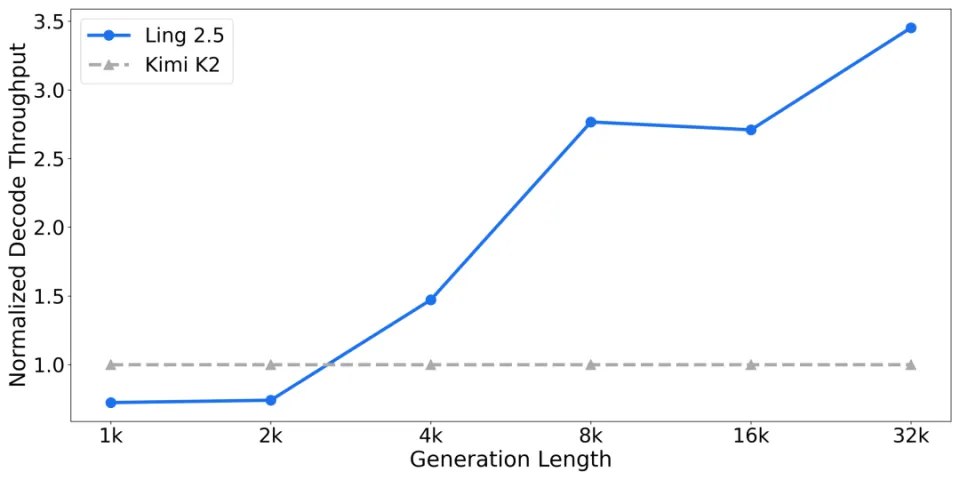

实测显示,与KIMI K2(激活参数32B)相比,新架构在长视野任务执行的吞吐量上仍保持明显优势。

且生成长度越长,该吞吐量优势越显著。

在超32K生成长度下,Ling 2.5访存规模降低超10倍,生成吞吐飙升3倍还要多。

在不同生成长度下的效率对比示意:生成长度越长,吞吐优势越明显

不仅如此,团队还将混合线性注意力架构,在强化学习方面进行了大规模扩展。

Ring-2.5-1T在数学、编码、智能体等任务上的「神勇」表现,源于其训练底层逻辑的重构。

不同于只看结果的传统训练,Ring-2.5-1T还引入了「密集奖励」(Dense Reward)机制,严密控制思考过程中每一步逻辑。

这种对推理路径的精雕细琢,显著减少了逻辑漏洞,让模型Ring-2.5-1T掌握了更高阶的数学证明技巧。

通过大规模全异步Agentic RL训练,Ring-2.5-1T培养出极强的多步规划、自主执行的能力。

由此,Ring-2.5-1T可以轻松接入Claude Code、OpenClaw等AI助手智能体编程框架。

总言之,Ring-2.5-1T背后万亿级混合线性注意力架构的创新,重塑了「深度思考」和「长程推理」的边界。

继Ring-1T之后,Ring-2.5-1T是蚂蚁团队,在推理模型结构与行动能力上的进一步探索。

得益于Ling 2.5架构,万亿参数的Ring-2.5-1T有效缓解了长文档处理、复杂任务规划中的计算瓶颈。

目前,Ring-2.5-1T的权重和推理代码已在Hugging Face与ModelScope上正式上线。

Hugging Face:https://huggingface.co/inclusionAI/Ring-2.5-1T

ModelScope:https://modelscope.cn/models/inclusionAI/Ring-2.5-1T

同时,模型也登陆到了InclusionAI社区,可以直接前往下载。

在这里,除了Ring-2.5-1T外,还汇集了蚂蚁团队发布的Ming-flash-2.0等100多种优质模型。

传送门:https://github.com/inclusionAI

这一里程碑式的开源,是蚂蚁团队在底层基础设施与巅峰算法优化上的一次降维打击。

从硬核奥数竞赛到深度集成Agent框架,Ring-2.5-1T为开发「真·干活」的AI助手,提供了强悍的高性能底座。

人手一个超级智能体,不是未来,是当下正在发生的现实。