开发者狂喜:Thinking Machines发布首款产品Tinker,后训练麻烦全给包了

机器之心编辑部

对于大模型开发者 / 研究者来说,今天是重要的一天。

因为刚刚,OpenAI 前 CTO Mira Murati 创办的 Thinking Machines 推出了首款产品 ——Tinker。

简单来说,Tinker 是一个 API,用于帮开发者 / 研究人员微调语言模型。重要的是,在此过程中,你只需要专注于训练数据和算法,而你不擅长的关于 Infra 的部分 —— 调度、调优、资源管理和 Infra 可靠性 —— 统统由 Tinker 来搞定,这将大大简化 LLM 的后训练过程。

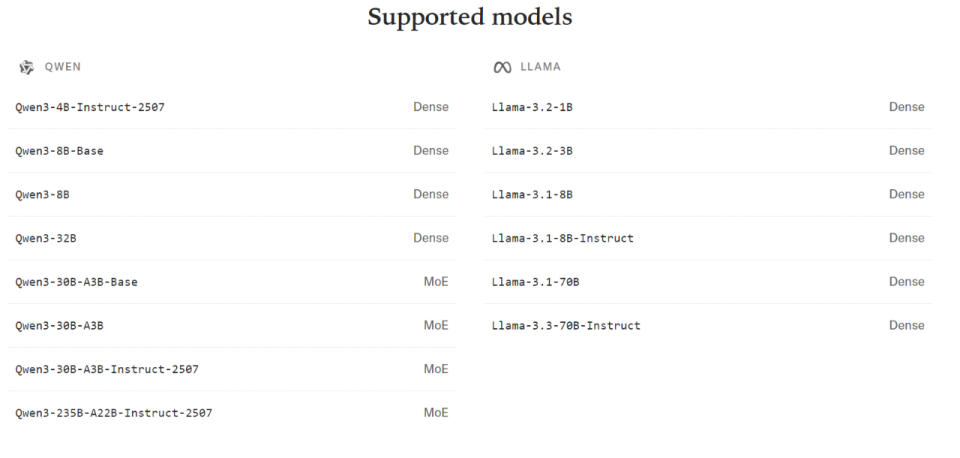

目前,Tinker 支持的模型如下所示,Qwen-235B-A22B 等前沿模型都包含在内。该公司表示,从一个小模型切换到一个大模型,就像在你的 Python 代码中更改一个字符串一样简单。Tinker 的发布是 Thinking Machines 使命的表现,即让更多人能够研究尖端模型并根据自己的需求进行定制。

Tinker 使用 LoRA 技术,以便在多个训练运行之间共享同一计算资源池,从而降低成本。 在前几天的一篇博客中,Thinking Machines 专门写了一篇博客介绍他们在 LoRA 方面的研究进展(参见《Thinking Machines 又发高质量博客:力推 LoRA,不输全量微调》)。

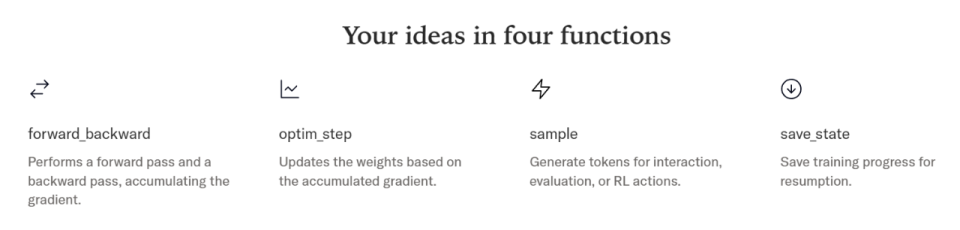

Tinker 的 API 为开发者提供了诸如 forward_backward 和 sample 之类的底层原语,这些原语可用于表达大多数常见的后训练方法。即便如此,要取得好的结果仍需要处理好许多细节。这就是为什么他们要发布一个开源库 ——Tinker Cookbook,其中包含基于 Tinker API 运行的后训练方法的现代实现。

伊利诺伊大学香槟分校博士生金博文表示,Tinker 的 Cookbook 中收录了他们的训练工具 ——Search-R1,这个工具可以「边推理边搜索」,感兴趣的读者可以参见《UIUC 联手谷歌发布 Search-R1:大模型学会「边想边查」,推理、搜索无缝切换》。

目前,普林斯顿大学、斯坦福大学、加州大学伯克利分校和 Redwood Research 的团队已经在使用 Tinker:

普林斯顿大学 Goedel 团队训练了数学定理证明器。使用 Tinker 和 LoRA,仅用 20% 的数据,他们的模型性能与全参数 SFT 模型(如 Goedel-Prover V2)相当。他们在 Tinker 上训练的模型在 MiniF2F 基准测试中达到了 88.1% 的 pass@32,通过自我校正后达到了 90.4%,超过了更大的封闭模型。

斯坦福大学的 Rotskoff 化学小组对一个模型进行了微调,以完成化学推理任务。在 LLaMA 70B 之上应用强化学习后,IUPAC 到公式的转换准确率从 15% 提升至 50%,研究人员称这一提升是以前在没有重大基础设施支持的情况下难以实现的。

加州大学伯克利分校的 SkyRL 小组在一个定制的异步 off-policy 强化学习训练 loop 上进行了实验,该 loop 涉及多智能体和多轮工具使用。得益于 Tinker 的灵活性,这些变得可行。

Redwood Research 利用 Tinker 对 Qwen3-32B 在长上下文 AI 控制任务上进行 RL 训练。研究员 Eric Gan 表示,如果没有 Tinker,他可能不会进行这个项目,他指出,多节点训练的扩展一直是一个障碍。

这些示例展示了 Tinker 的通用性 —— 它支持经典的有监督微调和高度实验性的强化学习(RL)pipeline,跨越了广泛的领域。

Tinker 正面向研究人员和开发人员进行内部测试,waitlist 也已开放申请。参与测试的 Anyscale 公司 CEO Robert Nishihara)表示,虽然像 VERL 和 SkyRL 这样的其他微调工具已经存在,但 Tinker 提供了卓越的抽象性与可调节性的结合(Tinker 抽象出了分布式训练的细节,但仍然让大家完全控制数据和算法)。

已经试用 Tinker 几周的加州大学伯克利分校计算机科学博士研究生 Tyler Griggs 则表示,许多强化学习微调服务都是面向企业的,不允许你替换训练逻辑。使用 Tinker,你可以忽略计算,只需对环境、算法和数据负责即可。

waitlist 链接:https://thinkingmachines.ai/tinker/

Tinker Cookbook 链接:http://github.com/thinking-machines-lab/tinker-cookbook

Thinking Machines 表示,Tinker 在起步阶段将免费使用。在接下来的几周内,他们将推出基于使用情况的定价模式。

Tinker 的发布给了广大开发者微调自己模型的机会,而这可能带来更多样化的产品创新。

AI 大牛 Karpathy 评价说,「我认为,社区还需要进一步探索 —— 在什么情况下、以什么方式进行微调才真正比直接用『大型模型加提示』更合适。 从我目前看到的一些迹象来看,微调的作用其实并不是为了给大语言模型『加风格』或『个性化』,而是为了收窄模型的任务范围,尤其是在你拥有大量训练样本的时候。 一个极端的例子就是各种分类器,比如垃圾邮件过滤器、内容过滤器等 —— 这些都是范围极窄的模型。当然,微调的应用范围应该远不止于此。但相比于为大模型设计一个复杂的 few-shot 提示,直接微调一个更小、专门针对某个细分任务的模型,往往效果更好、速度也更快。

现在,大语言模型在实际生产中的应用越来越多是通过大型管线(pipeline)来实现的,也就是多个模型以有向无环图(DAG)或流程(flow)的方式协同工作。在这些系统里,有的部分用提示就能很好地完成任务,但有相当多的环节其实更适合通过微调来实现。」

Murati 表示,Thinking Machines 实验室希望揭开调整世界上最强大的人工智能模型所涉及工作的神秘面纱,让更多人能够探索人工智能的极限。她说:「我们正在让原本只有前沿团队具备的能力惠及所有人,这完全是改变游戏规则的。外面有大量聪明人,我们需要尽可能多的聪明人来进行前沿人工智能研究。」

该公司开放大模型微调流程的计划也体现了其对开放的承诺。Murati 还表示,她希望 Tinker 将有助于扭转商业人工智能模型日益封闭的趋势。「如果你看看前沿实验室正在做的事情,以及学术界其他聪明人士在做的事情,它们之间的分歧越来越大,」她说。「如果你想想这些强大的系统将如何进入世界,这种情况可不太妙。」

参考链接:

https://thinkingmachines.ai/tinker/

https://www.wired.com/story/thinking-machines-lab-first-product-fine-tune/

https://venturebeat.com/ai/thinking-machines-first-official-product-is-here-meet-tinker-an-api-for