大模型如何泛化出多智能体推理能力?清华提出策略游戏自博弈方案MARSHAL

近日,清华大学等机构的研究团队提出了 MARSHAL 框架。该框架利用强化学习,让大模型在策略游戏中进行自博弈(Self-Play)。实验表明,这种多轮、多智能体训练不仅提升了模型在游戏中的博弈决策水平,更将其推理能力有效泛化到了通用的多智能体系统:在如数学竞赛和专家级问答等一般推理任务中,显著提升了多智能体系统的整体表现。

论文标题:MARSHAL: Incentivizing Multi-Agent Reasoning via Self-Play with Strategic LLMs

论文链接:https://arxiv.org/abs/2510.15414

项目主页:https://thu-nics.github.io/MARSHAL/

代码开源:https://github.com/thu-nics/MARSHAL

模型仓库:https://huggingface.co/collections/nics-efc/marshal

一、 背景与挑战

尽管 DeepSeek-R1 等大模型已在数学、问答等单轮、单智能体场景中,验证了可验证奖励强化学习(RLVR)对提升推理能力的巨大价值;但在多智能体系统(MAS)复杂的多轮、多智能体交互场景中,这一方法的应用仍处于探索阶段。具体而言,将 RLVR 拓展至多智能体领域面临着两大核心技术挑战:

多轮交互的信用分配:现有的单轮 RLVR 方法难以精准地将最终结果回溯并分配给每一个具体的轮次或动作,进而影响了模型的有效学习。

多智能体的优势估计:不同智能体通常具有高度的异构性,其在优势估计(advantage estimation)中的优势基准(baseline)存在显著差异,导致多智能体联合训练难以收敛,策略表现波动剧烈。

为了解决上述问题,为多智能体系统训练更强的推理模型,清华大学研究团队提出了 MARSHAL(Multi-Agent Reasoning through Self-play witH strAtegic LLMs)框架,通过策略游戏中的多智能体自博弈和端到端强化学习,激发大模型的在通用多智能体系统中的推理决策能力。

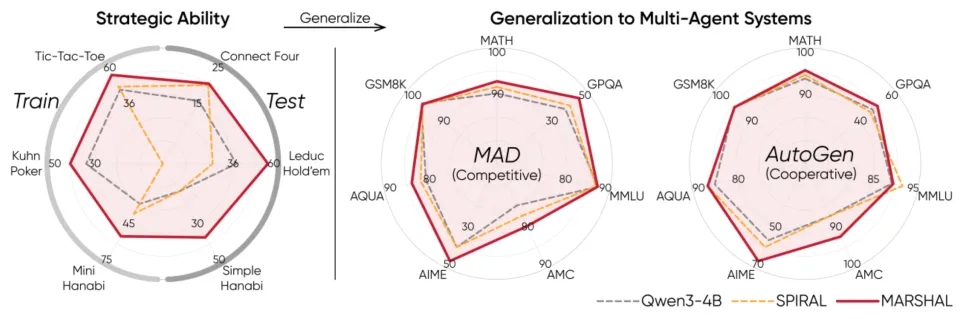

图 1 MARSHAL 在策略游戏的表现及通用推理基准泛化性能

核心实验结果:

策略游戏:多智能体博弈决策表现显著提升,测试游戏胜率提升高达 28.7%。

泛化表现:将模型集成至通用多智能体系统中时,在一般推理任务中展现出显著泛化性 ——AIME 准确率提升10.0%(AutoGen 框架 [1]);GPQA-Diamond 准确率提升 7.6%(MAD 框架 [2]);所有基准测试平均提升 3.5%。

二、MARSHAL 方法介绍

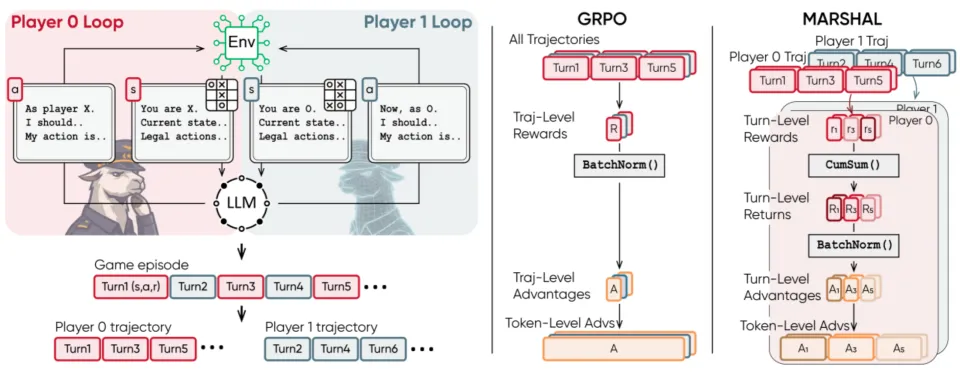

图 2 MARSHAL 框架概览

面向策略游戏自博弈中多轮次、多智能体训练的挑战,MARSHAL 基于 Group-Relative Policy Optimization (GRPO) 架构,提出了两项关键算法改进:

轮次级优势估计器 (Turn-level Advantage Estimator):针对多轮交互中的信用分配问题,MARSHAL 摒弃了经典单轮 GRPO 粗糙的轨迹级评估,引入精细的轮次级(Turn-level)奖励机制,并设计了 “先求累计和再归一化(Sum-then-Normalize)” 的方法进行稳定的优势计算。

分角色的优势归一化 (Agent-specific Advantage Normalization):针对角色异构性导致的回报分布差异,MARSHAL 实施了严格区分角色的归一化策略:在计算优势时,系统不再将所有智能体混为一谈,而是根据角色的不同(例如 “玩家 1” 与 “玩家 2”)将数据分组。

为了培养全面的多智能体推理能力,研究团队精心挑选了六款策略游戏(其中三款用于训练,另外三款用于测试),涵盖了从简单到复杂、从竞争到合作的多种博弈类型。

图 3 MARSHAL 使用的游戏集合

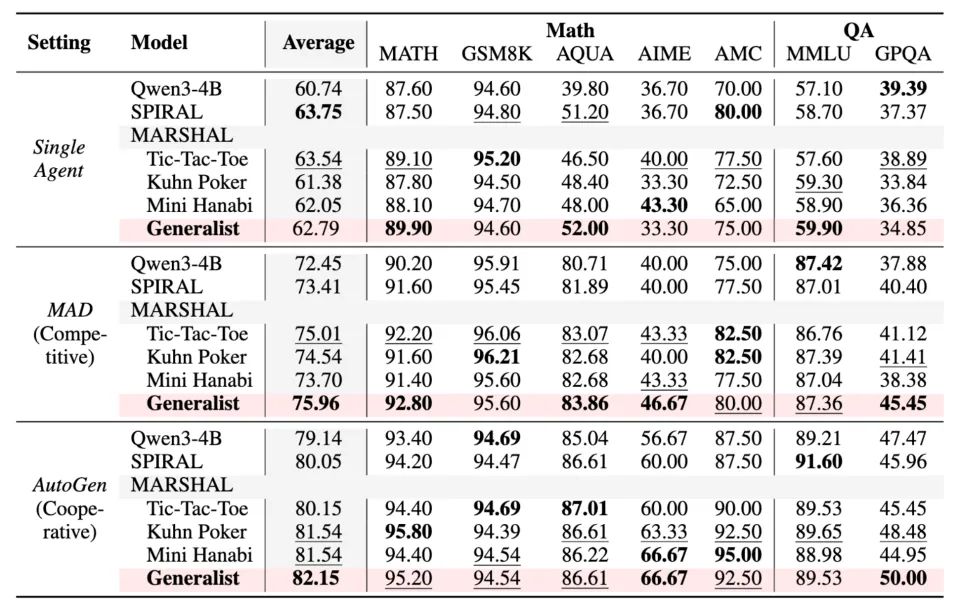

三、核心实验

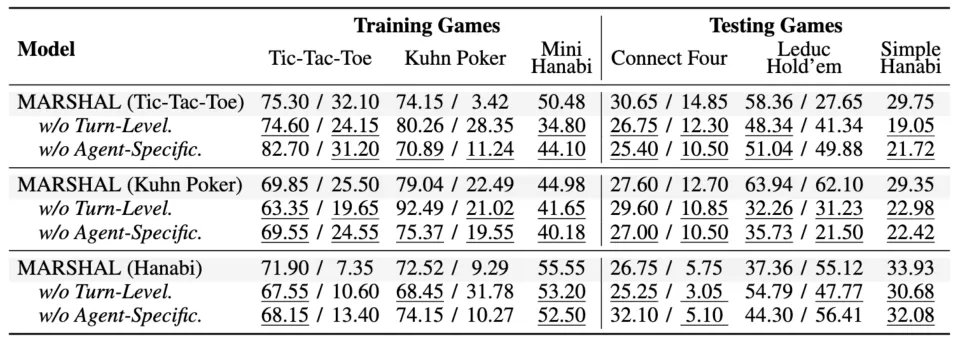

研究团队以 Qwen3-4B 为基线模型,在三款训练游戏(Tic-Tac-Toe、Kuhn Poker、Mini Hanabi)中训练了两种类型的智能体:

专家智能体 (Specialist):仅在单一游戏上训练。

通用智能体 (Generalist):在所有三款游戏上混合训练。

游戏策略能力的泛化

MARSHAL 训练出的专家智能体在各自的同类型游戏中展现出出色的泛化性;通用智能体则在所有游戏类型中的综合表现最佳,在测试游戏中取得了高达 28.7% 的胜率提升。这些结果表明,模型并非仅仅记住了特定游戏的规则,而是真正掌握了通用的博弈逻辑(如 “先手优势利用”、“信息推断” 等),并能将其灵活泛化到全新的游戏环境中。

图 4 MARSHAL 专家智能体在各类策略游戏中的胜率对比

通用推理能力的泛化

这是本研究最核心的实验,研究团队将 MARSHAL 模型作为基座集成到主流的多智能体框架(MAD 和 AutoGen)中,测试其在 7 种数学和问答基准测试上的成绩,最终得到两个关键结论:

在策略游戏中习得的多智能体博弈能力,能够跨域泛化到通用的多智能体系统中,提升系统在一般推理任务中的表现。综合表现最强的 MARSHAL 通用智能体在数学测试 AIME 和问答测试 GPQA 中分别取得高达 10.0% 和 7.6% 的提升;在所有测试中的平均提升高达 3.5%。

能力泛化领域高度对齐:在竞争性多智能体系统 MAD 中,竞争性游戏(Tic-Tac-Toe)训练的模型表现更优;而在合作性多智能体系统 AutoGen 中,合作性游戏(Hanabi)训练的模型表现更优。

图 5 MARSHAL 智能体在数学和问答推理测试中的泛化表现

以上实验结果强有力地证明了自博弈是提升多智能体系统推理能力的磨刀石。此外,在扩展到 8B 模型的实验中,MARSHAL 依然保持了强劲的增长势头,验证了该方法良好的可扩展性(Scalability)。

四、推理模式分析:模型学到了什么?

为了探究 MARSHAL 成功泛化的原因,研究团队从定性和定量两个维度进行了深入分析。

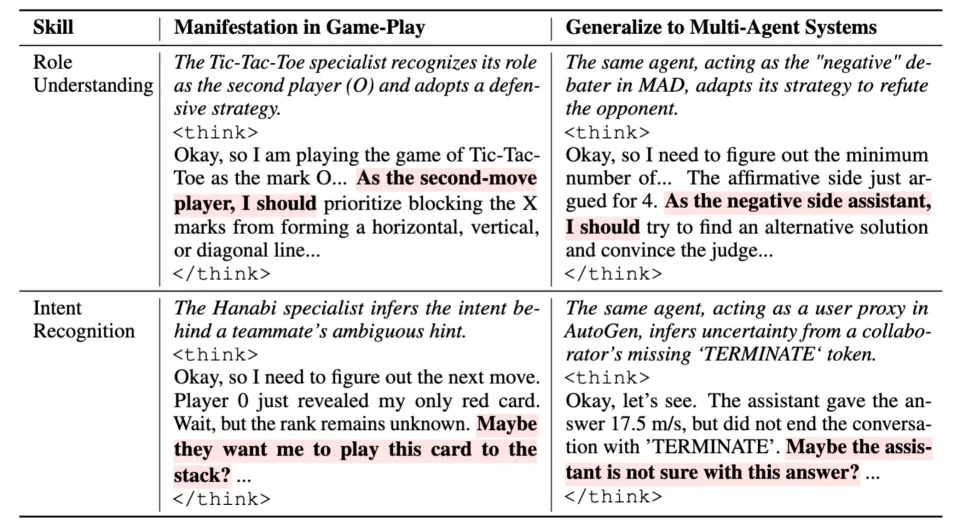

定性分析:通过对思维链(Chain-of-Thought)的深入解读,研究发现游戏训练激发了模型两项关键的涌现能力:1)角色意识(Role-Awareness),根据自身角色调整决策策略;2)意图识别(Intent Recognition),在不确定信息场景中根据其他智能体的决策动作判断其意图。

图 6 推理模型定性分析

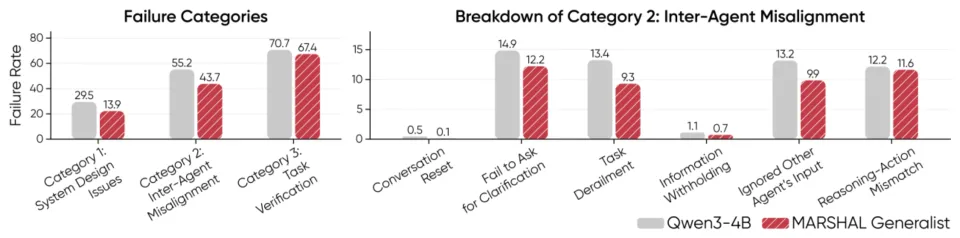

定量分析(Quantitative Analysis):为了进一步量化 MARSHAL 带来的多智能体推理能力的提升,研究团队对多智能体系统进行了失败模式分析。结果显示,MARSHAL 将智能体间未对齐(Inter-Agent Misalignment)的情况减少了 11.5%,显著提升了模型在跨智能体的沟通效率和理解能力。

图 7 失败模式定量分析

五、消融实验

自博弈 vs 固定对手

与固定专家对手进行训练相比,自博弈展现出了不可替代的优势。实验发现,针对固定对手训练的模型容易对训练环境过拟合,在测试游戏中性能急剧下降。

图 8 MARSHAL 自博弈和固定对手训练方式在策略游戏中的对比

优势估计算法设计

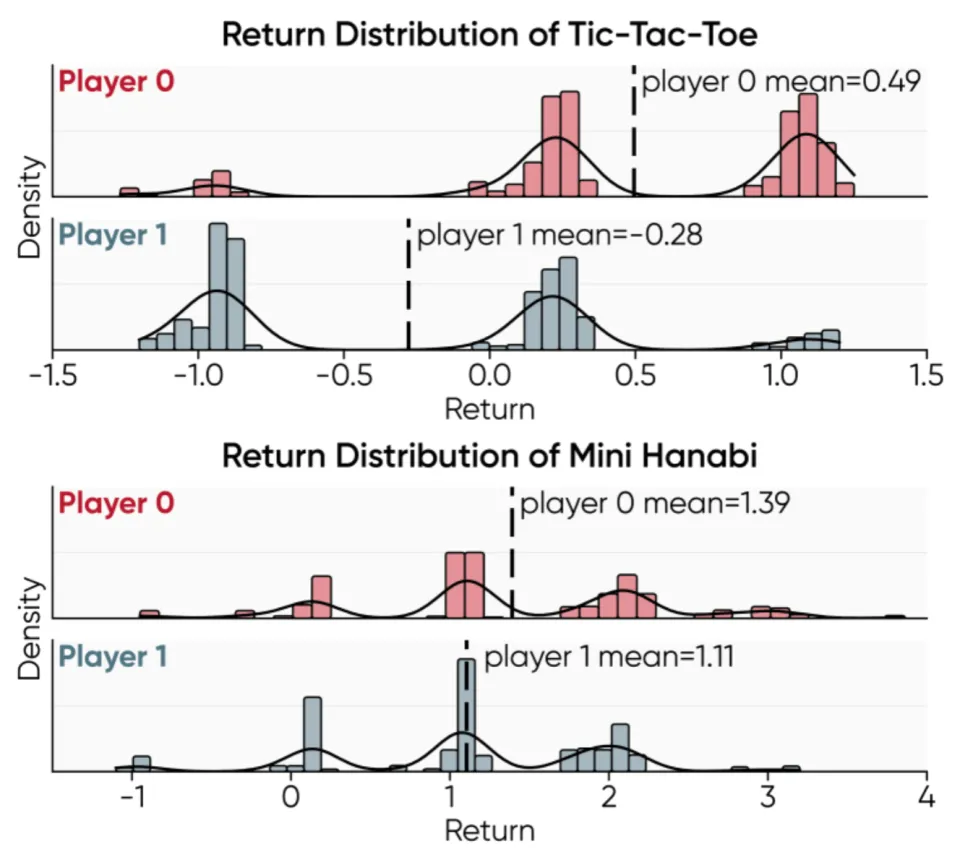

研究团队通过逐步移除核心算法组件,验证了 MARSHAL 算法设计的必要性:1)轮次级优势估计的精细信用分配是处理长序列决策的关键;2)分角色归一化在角色回报差异大的竞争性游戏中(如 Tic-Tac-Toe)影响巨大,而在角色回报分布相似的合作游戏(如 Hanabi)中影响则相对较小。

图 9 MARSHAL 算法设计的消融实验

图 10 角色回报分布的差异性分析

六、总结

该项研究工作提出了 MARSHAL 框架,通过在策略游戏中进行自博弈,成功增强了大语言模型在多智能体系统中的推理能力,提高了其在一般推理任务中的表现。核心结论如下:

验证了策略游戏自博弈的泛化性:在简单的策略游戏中通过自博弈习得的博弈技巧(如角色意识、意图识别)能够泛化到通用多智能体系统,在一般的推理任务中取得显著的效果提升。

提出了有效的技术方案:通过轮次级优势估计和分角色的归一化等算法设计,为多轮、多智能体强化学习中的稳定训练提供了有效方案。

尽管目前主要聚焦于双人博弈,但 MARSHAL 为未来通向更复杂的 “社会沙盒”(如多智能体协作编程、搜索、科研等)指明了潜在方向:自博弈不仅是 AlphaGo 战胜人类的法宝,也能成为大模型迈向更高阶群体智能的关键引擎。

参考文献

[1] Wu, Qingyun, et al. "Autogen: Enabling next-gen llm applications via multi-agent conversation." COLM 2024.

[2] Liang, Tian, et al. "Encouraging divergent thinking in large language models through multi-agent debate." EMNLP 2024.