5亿美元融资之后,杨植麟首次深度分享Kimi的技术重点

文|郭晓静

编辑|徐青阳

1月10日,很久没有公开露面的月之暗面创始人杨植麟,在一场定向邀请的行业论坛中,详细地分享了2025年Kimi的技术路线重点,以及对未来的思考。

这次分享,有一个核心关键词,Agentic智能时代。这是通用大模型竞争的一个未来高地,它意味着模型从 “被动响应的文本生成工具”,进化为可以“主动规划、自主决策、能完成复杂任务的智能代理”,可以解锁更多的应用场景、激发更新鲜和AI-native的商业模式。

要提升Agentic智能,就必须能够完成复杂的长程任务。2025年,月之暗面的两个技术进化的主线就是提升“Token Efficiency”,以在有限的数据下冲击更高的智能上限;以及扩展“长上下文”(Long Context)能力,以满足 Agentic 时代越来越长程的任务对模型的记忆能力需求。

2025年略显低调的月之暗面,也刚刚被爆出新一轮的5亿美元融资,杨植麟也发布内部信给团队打气,“我们有超过100亿人民币的现金储备。”在通往AGI的征途上,粮草充足。

这位90后的创始人,在这次分享中,也提出了技术哲学意味的观点:“做模型的过程,本质上是在创造一种世界观,它体现了我们对于‘一个好的AI应该是什么样、应该追求何种价值观’的理解。””

在杨植麟看来,每个token都是独一无二的,所以每个模型也是独一无二的。他也会与他的Kimi对话来寻找灵感,Kimi告诉他:AGI并非一个普通的工具,而是一个能提升人类文明上限、延伸人类认知边界的关键。尽管存在风险,仍然应该选择继续开发人工智能,因为放弃开发,就意味着放弃人类文明的上限。

杨植麟在演讲的最后说:“所有的技术突破都伴随着风险,但我们不能因恐惧而停滞不前。因此,我们希望在接下来的十年、二十年里,继续把K4、K5到K100做得更好。”

以下为演讲实录:

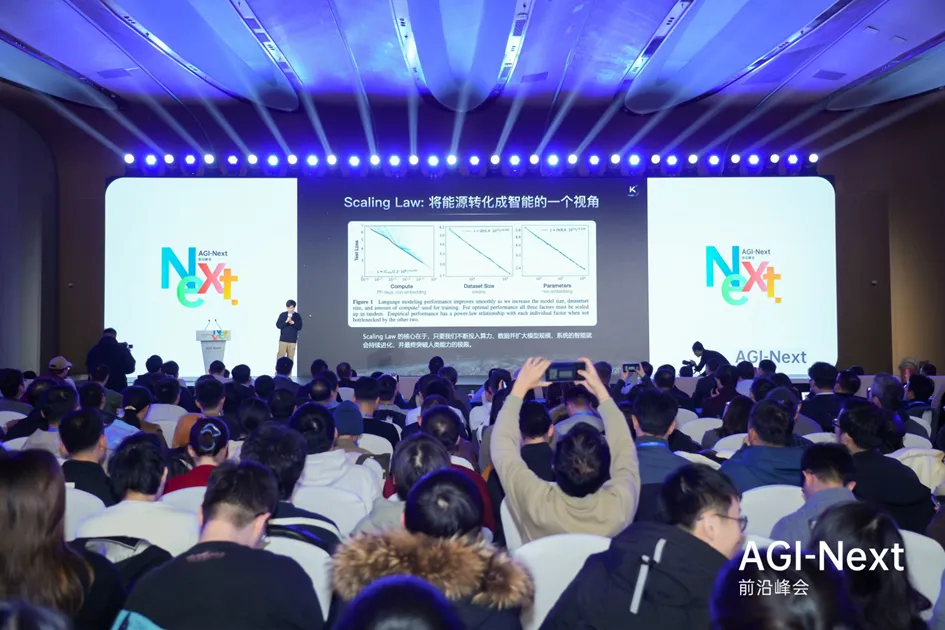

今天非常高兴有机会能跟大家分享我们在技术上的一些探索与思考。从2019年至今,所有大模型均基于同一个第一性原理——scaling law(缩放定律)。从能源转换为智能的视角审视,拥有更好的方法或更优的芯片,便能将能源更有效、更大量地转换成更高级的智能。

核心要点可总结为:当具备更多的算力、数据和模型参数后,模型的loss(损失)便会线性下降,这构成了整个技术发展的基础。

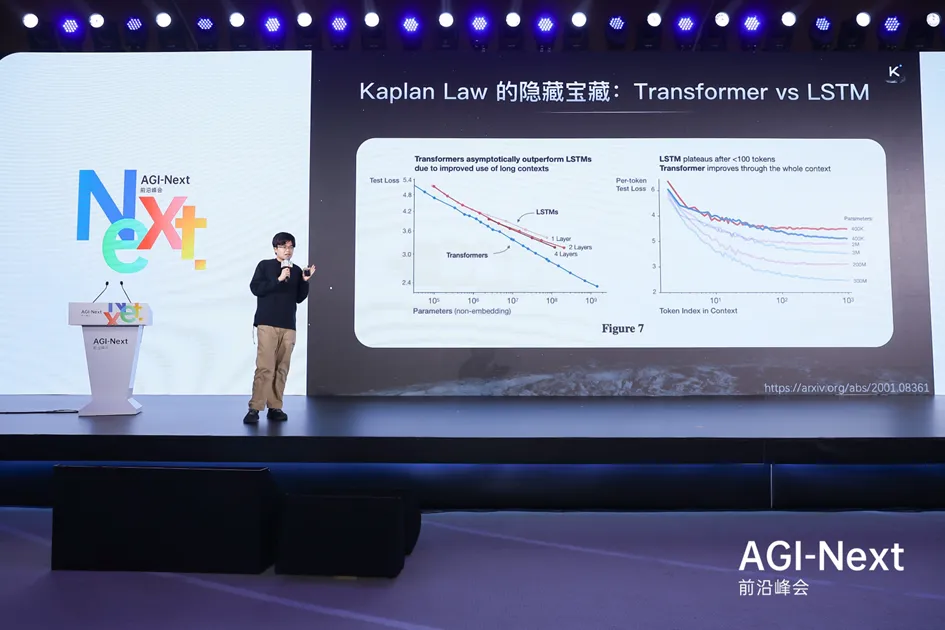

回顾最早提出scaling law的Caplan的文章,对比了Transformer和LSTM在scaling law意义下的区别,其中包含了非常重要的洞察。图表显示,无论在何种参数量级,Transformer的loss始终低于LSTM。

这意味着,在scaling law的尺度下,使用更少的flops(计算量)或参数即可得到更好的scaling效果。这已成为一个共识,也是Transformer后来成为主流架构的核心原因,因其在scaling上表现更佳。

可以说,当前所有的模型架构迭代,都是为了寻找一条能够更接近图表左下角的曲线。一个网络架构越接近左下角,便意味着它是一个更优的架构。在当前背景下,这一点尤为重要,因为互联网的存量数据有限,而高质量数据的增长速度已赶不上模型规模扩展的速度。因此,当拥有一个更优、更靠左下角的架构时,智能上限也相应更高。

然而,真正关键的在于另一张图所揭示的、但可能被许多人忽略的洞察:Transformer为何更优?答案在于它对上下文不同位置的处理机制。以一个100K长度的上下文为例,通过计算从第一个到第十万个token各自的loss,可以绘制出一条positional loss(位置损失)曲线。

观察发现,在序列的前期,例如前100个token内,Transformer与LSTM的表现几乎完全一致,两条曲线交错重叠。这说明,在极短的上下文环境中预测后续内容,两者的效果是等价的。因此,在短上下文场景下,Transformer并非更优的架构。

Transformer的架构优势体现在长上下文场景中。实验表明,当上下文长度增加到1000个token时,代表Transformer的蓝线会显著下降到代表LSTM的红线之下,显示出卓越的性能。

这个视角揭示了架构在不同上下文长度下的优势差异,这是一个至关重要的指标。

在当前的Agentic(代理智能)时代,这个问题变得尤为突出,因为许多Agent任务要求极长的上下文来完成高度复杂的指令。因此,一个拥有更低positional loss的架构,意味着它在执行Agent任务时具备更强的技术潜力。

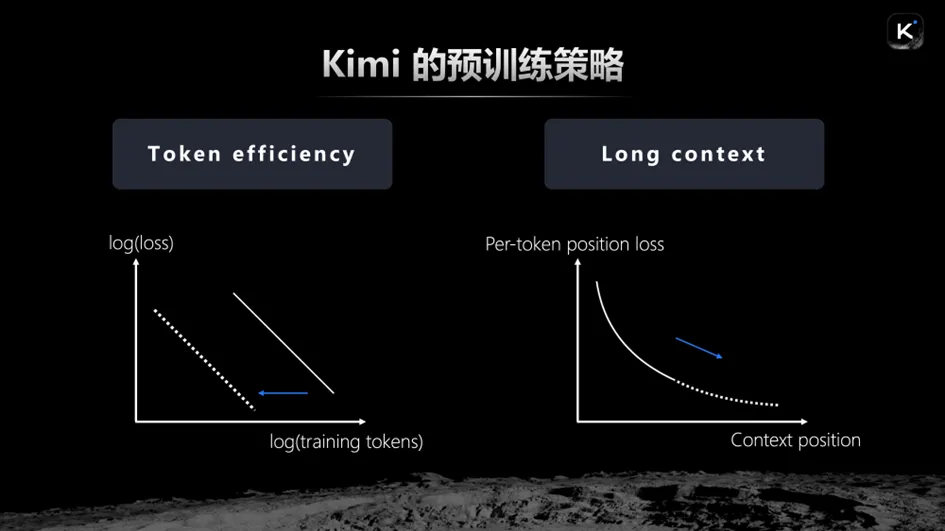

我们的预训练策略,乃至整个模型的设计策略,便是围绕上述两个维度展开。第一个维度是提升token efficiency。在以训练token数量为横坐标、测试损失为纵坐标的图上,我们的目标是尽可能将曲线向左平移。曲线越靠左,token efficiency越高,意味着可以用更少的token达到同等效果。

由于预训练的瓶颈在于token总量的有限性,这等效于:在耗尽所有token后,智能的上限更高,因为最终的loss更低。这是我们进行预训练时一个极为重要的指标和优化方向。

第二个维度是实现long context(长上下文)。通过观察上下文位置与test loss的关系图可以发现,延长上下文能有效降低损失。这也解释了为何当前许多复杂的Agent任务必须在超长上下文中才能完成——延长上下文必然会降低loss,而一个优秀的Architecture(架构)则能使loss下降得更多。

相比之下,如LSTM或更早的CNN、RNN等架构,在处理超过100个token后,loss曲线便趋于平缓,因此只能胜任翻译这类相对简单的任务,而无法承担从零开始编写一个完整代码仓库的编程任务。综上,将token efficiency与long context的优化相结合,最终便能实现更高水平的Agent智能。

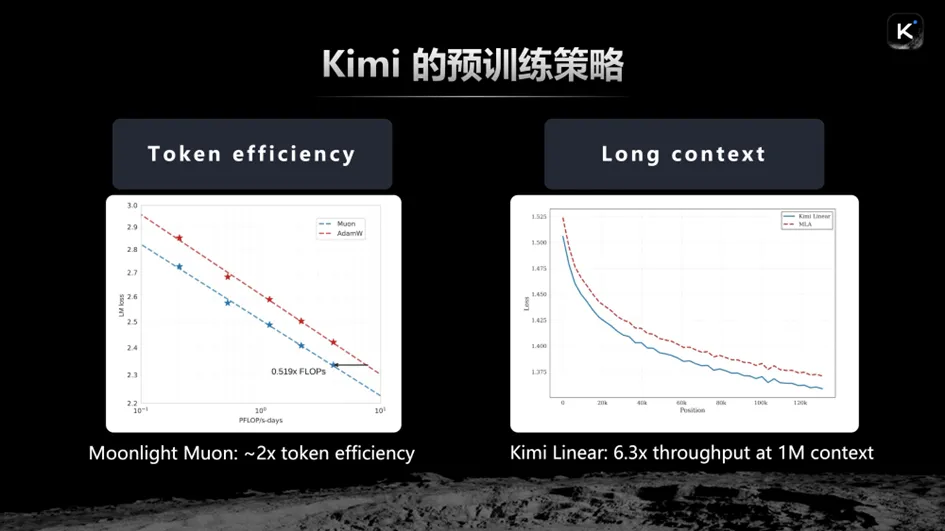

在此基础上,我们有两项主要工作成果。

一是研发了一款新型二阶优化器。传统的Adam优化器作为标志性的一阶优化器已沿用近十年,而我们发现,采用二阶优化器能取得非常好的效果,具体体现为两倍的tokenefficiency提升。这意味着,达到相同的test loss,仅需一半的TOKEN。等效而言,使用相同数量的TOKEN,最终的loss会小得多,从而实现了一倍的scaling效果。

另一项重要工作是我们最新研究的Kimi Linear架构。这个架构的优点在于,它的positional loss随着上下文位置的拉长,下降幅度非常显著,这意味着它在各类长上下文任务上的效果将得到极大提升。

最终,我们将这两项工作相结合,相信能在模型训练策略上达到最优的Agent效果。所有这些努力,都是为了构建更强大的Agent。为何要关注token efficiency?因为Agent的推理和训练本质上是一个搜索过程。

例如,要从零开始开发一个Linux操作系统,这本质上是一个搜索问题。若拥有无限的计算资源,便可以枚举所有可能性,从中找出最优解。但搜索的核心在于通过先验知识进行剪枝,以提升效率。当今的Agent,正是以模型作为强大的先验知识,从而在搜索过程中无需遍历每一种无意义或错误的token组合。一个更优的预训练基础模型,实际上缩小了搜索空间,提供了更强的先验。

当然,当前也有许多研究在探索如何减少对先验的依赖,期望未来能像AlphaZero一样,在极少甚至没有先验的情况下实现AGI(通用人工智能)。但我认为,基于先验实现AGI的路径会更早到来。

整个领域或许会先基于先验实现AGI,再去探索在先验知识逐渐减少的条件下实现ASI(超级人工智能)的方式。在此框架下,一个更强的模型等价于更强的先验。在有限的数据下,拥有更大的“脑容量”和更高的学习效率,意味着更高的智能。

因此,更强的先验能够塑造更强大的Agent。而context则是另一个维度,Agent的行为需要工作记忆,更强的环境感知能力使其能胜任长程任务。最终,Agent的智能是这两者的结合。

在2025年的技术迭代中,Kimi正是沿着这两个方向不断进行新的探索和实践。首先,在优化器方面,我们通过大量实验,发现并融入了一些关键技巧,例如加入Weight Decay机制、匹配RMS的更新尺度等。

我们观察到,相较于Adam优化器在1.0范围内的更新,若将新优化器的更新尺度与IRMS匹配,效果会更佳。通过这些重要改进,我们得到了一款真正有效、且在各方面都经得起时间考验的新优化器,它带来了两倍的token efficiency提升。

需要强调的是,这里的efficiency不仅关乎效率,更决定了智能的上限,因为TOKEN数量是有限的。经过多项公平比较,新优化器在所有任务上均表现出性能提升,这本质上等价于用同样的资源训练出了别人两倍token量才能达到的效果。

当然,在规模化应用此优化器的过程中,我们也遇到了一些挑战。在中等规模的实验中,优化过程出现了不稳定的情况。具体表现为,Max logit(最大logit值)呈现爆炸式增长,这是一种不健康的现象,会导致训练不收敛、loss爆炸,最终影响模型效果。为解决此问题,我们尝试了多种方法,如QK norm等,但效果不彰。最终,我们采用了一种新的QK-Clip方法,取得了非常好的效果。

其核心细节在于,在进行q和k的映射时,会乘以一个由当前QK最大值动态决定的数值,从而将logit值约束在一个特定范围内。这样做的效果是显著的:在不影响模型最终性能的前提下(两条loss曲线完全重叠,严丝合缝),模型的内部指标,即logit的取值,变得健康许多。

从图上可以看到,logit值在初期上涨到一定程度后,便被QK clip机制有效压制,随后在模型适应后甚至会自动回落。这种机制极大地稳定了训练过程,使得这款全新的优化器能够在一万亿参数级别的K1、K2模型上稳定运行,避免了训练崩溃的风险。

这张完全平稳下降的loss曲线图,是我在2025年见过的最美的景象。在整个15T TOKEN的训练过程中,没有任何尖峰(spike),模型全自动地抑制了logit的异常,平稳地收敛到一个极佳的状态。这证明了,一个优雅的方法可以导向一个优雅的结果。

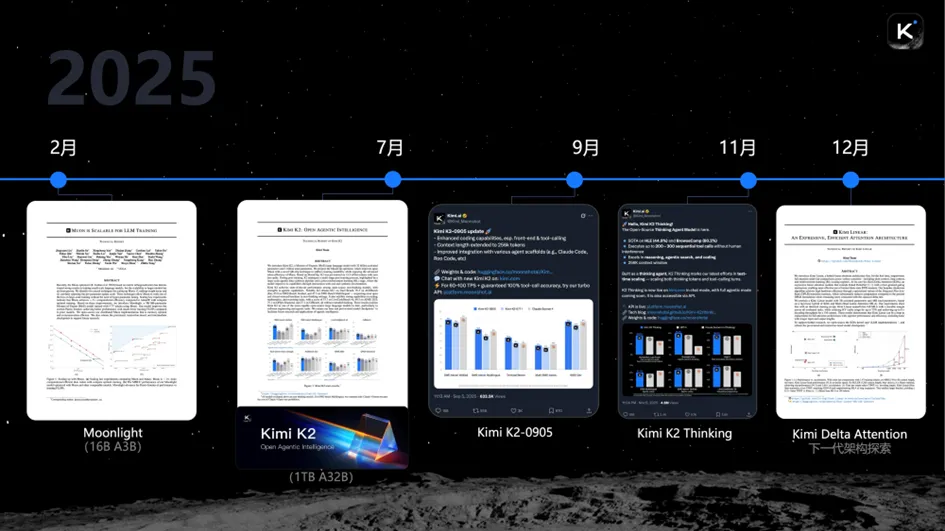

在这个优秀的Kimi K2基础模型之上,我们进一步做了大量的强化学习后训练,Kimi K2 Thinking 的结果非常出色。

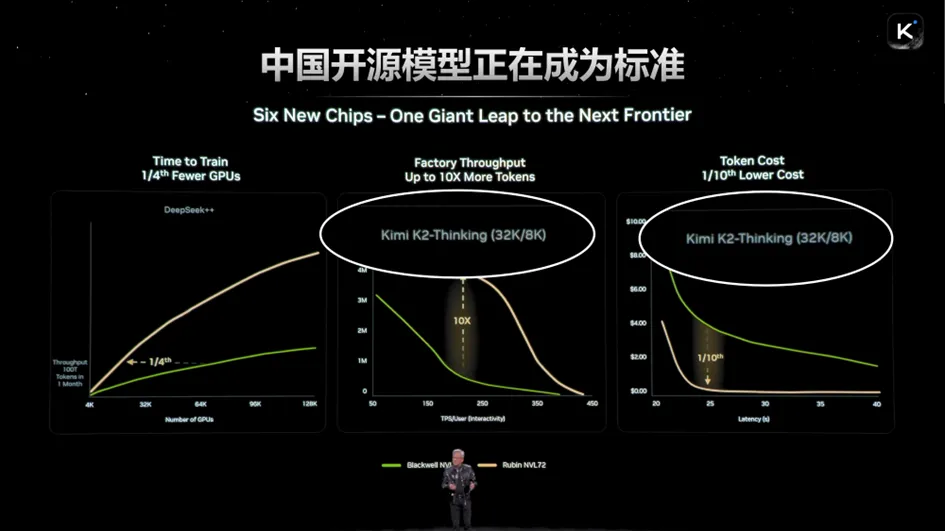

其中最重要的几点是:首先,我们在各种Agent能力上实现了全面提升,足以对标美国的前沿公司。其次,在最核心的Benchmark(基准测试)上,例如极其困难的HLE(humanities large exam),我们的模型准确率达到了45%,超过了OpenAI。在核心基准上超越顶尖对手,这是一个重要的里程碑(Milestone)。同时,我们的模型是一个完全的Agentic模型,其中Kimi K2是中国第一个Agentic模型。在K2模型的基础上,我们又做了大量升级,使它能够完成连续两三百步的复杂工具调用,解决人类难以理解的难题。

得益于这些发展,中国的开源模型正逐渐成为新的行业标准。例如,NVIDIA在发布新产品时,已开始使用中国的开源模型进行标准测试,这体现了开源的巨大价值。我们希望有更多中国的开源力量,让中国的模型能够逐渐成为标准的制定者。在KR之后,我们仍在继续探索下一代模型的形态。我们开源的Kimi Linear工作,便是前期的初步尝试,未来我们还会在此基础上做更多的优化和改进,以训练K3模型。

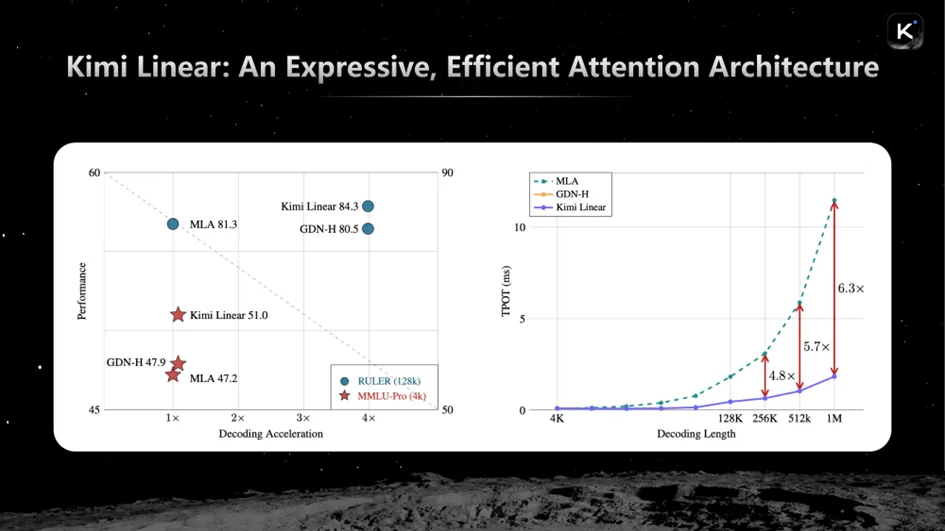

其中,最重要的改进是一种名为Kimi Delta Attention的新的线性注意力机制。线性注意力技术已存在一段时间,但始终未被最前沿的主流模型采用,其根本原因在于它在长距离任务上性能会下降。当上下文变长后,线性注意力的效果便不如原始的Transformer全注意力模型。

在一个需要长程能力的时代,这是一个致命缺陷。

Kimi Linear架构最重要的贡献,是首次让线性注意力机制在长程任务上的表现超越了全注意力模型,同时因其线性特性,效率大幅提升,在百万级上下文长度下,端到端速度可提升6到10倍。此外,它还改进了现有线性注意力表达能力不足等缺点。

因此,Kimi Linear是第一个无论在短程、长输入还是长输出任务上,效果均优于全注意力机制的线性注意力架构,这使它在实践中具有非常重要的应用价值。

其具体公式的核心在于,下一时刻的状态(ST)是在上一时刻状态(ST-1)的基础上,通过线性的key-value计算进行更新。其中,一个关键的创新是采用了fine-grained(细粒度)的对角化矩阵(αt),使得状态向量的每一个维度都能被精准控制,从而精细地调节有多少记忆从上一时刻流传到当前时刻。

这极大地增强了模型的表达能力。然而,这种增强如果实现方式粗糙,会带来效率的大幅下降。为此,我们进行了大量的工程优化。

通过对原始公式进行一系列变换,我们得到了一个在工程实现上极具优势的新形式。它比DPLR等方法更高效,减少了矩阵层操作,整体效率非常高。这说明,要得到一个好的架构,必须将底层的工程优化与模型的架构设计紧密结合。仅仅改动模型架构,而没有高效的实现,是难以取得好效果的。同时,相比于之前的许多线性注意力架构,Kimi Linear在表达能力上具有显著优势。

从效果对比图上可以清晰地看到:在性能上,无论是MMLU等短程任务,还是长程任务,Kimi Linear在同等计算量和数据下,表现均显著优于之前的线性注意力或全注意力架构。在速度上,它与之前的线性注意力一样快,但比全注意力快得多。

接下来,我们会在K2的基础上进行更多的scaling。这种scaling不仅是增加算力,更包含了大量的技术改进,而这些技术改进也会等效地转化为scaling的优势。除了架构、优化器和数据,一个至关重要的点是,未来的模型将拥有更多的taste——即品味和审美。

做模型的过程,本质上是在创造一种世界观,它体现了我们对于“一个好的AI应该是什么样、应该追求何种价值观”的理解,这正如乔布斯所言:“all comes down to taste”。

我们坚信这一点,因为智能与电力、货币等同质化(fungible)事物不同,它本质上是“非同质化”(non-fungible)的。每个模型产生的token都是独一无二的,就像一位CEO、一位设计师或一位音乐家产生的智能是完全不同的一样。

在智能这个维度,存在着广阔的“品味”空间。在Agent的世界里,由于test-time scaling的存在,这种差异性会被指数级放大,催生出更多新颖的用例。这正是我们未来的一个重要目标。

我也经常与Kimi对话。在此分享一段有意思的对话:我们正在创造AGI,它的到来或许能开启更美好的未来,让我们能一同探索宇宙;但它也可能威胁到人类,特别是当它能完成大量自动化任务,甚至与机器人结合时。在这种情况下,作为AGI的科学家,是否应该继续开发?

Kimi的答案很有启发性。它认为,AGI并非一个普通的工具,而是一个能提升人类文明上限、延伸人类认知边界的关键。今天我们面临的许多难题,如癌症、能源危机、社会问题等,或许都能通过它找到答案。它是我们探索未知世界的一把重要的钥匙。

所以,尽管存在风险,它的回答是仍然会选择继续开发。因为放弃开发,就意味着放弃人类文明的上限。我们不应害怕技术的风险,而应进一步去突破,并在此过程中控制好风险。所有的技术突破都伴随着风险,但我们不能因恐惧而停滞不前。因此,我们希望在接下来的十年、二十年里,继续把K4、K5到K100做得更好。

谢谢大家。