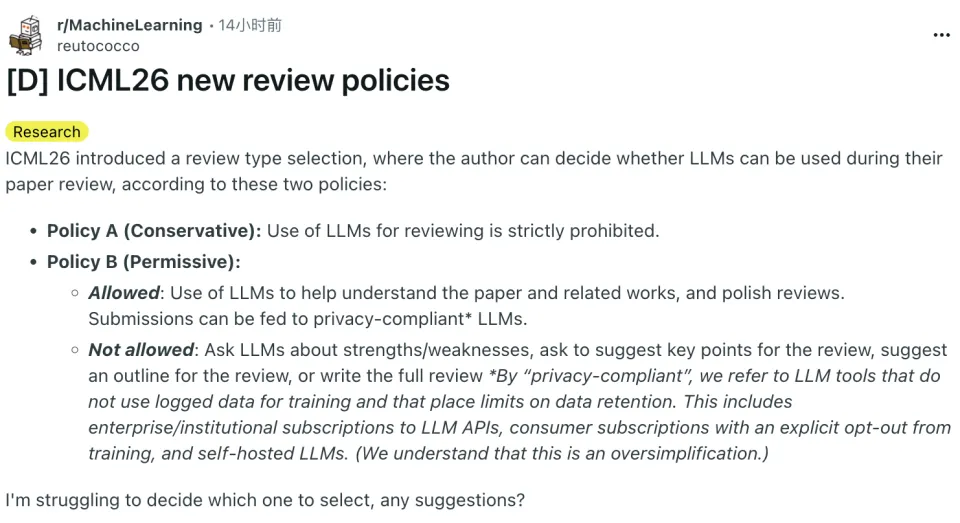

评审用不用AI,作者说了算?ICML 2026全新评审政策出炉

开始前,温馨提醒一下各位投稿 ICML 2026 的小伙伴们,投稿已于 1 月 8 日开放,也请大家注意投稿截止时间:

摘要提交截止日期:2026 年 1 月 23 日。

全文提交截止日期:2026 年 1 月 28 日。

两个月前,ICML 2026发布了征稿新规,我们也详细做了报道。

当时,为了应对大量的,超负荷的预期论文投稿量,以及其他顶会超负荷运行的前车之鉴,ICML 提出了互审数量限制和人工智能使用规定。

征稿要求中提到:评审过程中可能会使用 AI 工具辅助,但不会允许完全由 AI 执行评审。

已经投稿了论文的小伙伴或许已经发现了,这次 ICML 似乎有了一些新变化,并且是在征稿要求中没有详细说明的。

我们简单概括一下,ICML 2026 引入了评审类型选择机制,论文作者可以决定在其论文评审过程中是否允许使用大语言模型。

具体包括两种政策:

政策 A 是保守型,简单直白好理解:严格禁止在论文评审过程中使用任何大语言模型。

政策 B 是宽松型,允许使用大模型评审,但会议对使用大模型评审的方式做出了限制:

允许的行为:

使用大语言模型辅助理解论文内容及相关工作;

使用大语言模型对评审意见进行语言润色;

可将投稿论文提交给符合隐私合规要求的大语言模型。

不允许的行为:

向大语言模型询问论文的优点或缺点;

要求大语言模型总结或建议评审应关注的关键点;

要求大语言模型提供评审意见的结构或提纲;

要求大语言模型撰写完整的评审意见。

隐私合规大语言模型,是指不会使用日志数据进行训练、且对数据保留期限作出限制的模型工具。

这个小变化是比较新颖的。

过去,评审是否使用大模型,更多取决于评审人,或者处在一种默认被接受的灰色状态。这一次,ICML 明确把选择权交给了作者本身。在论文投稿量持续攀升、评审负担越来越重的现实下,ICML 既没有彻底禁止 AI,也没有完全放开 AI 评审,却给出了一个相对折中的方案。

问题在于,关于大模型使用的规定,执行起来一般都很困难。

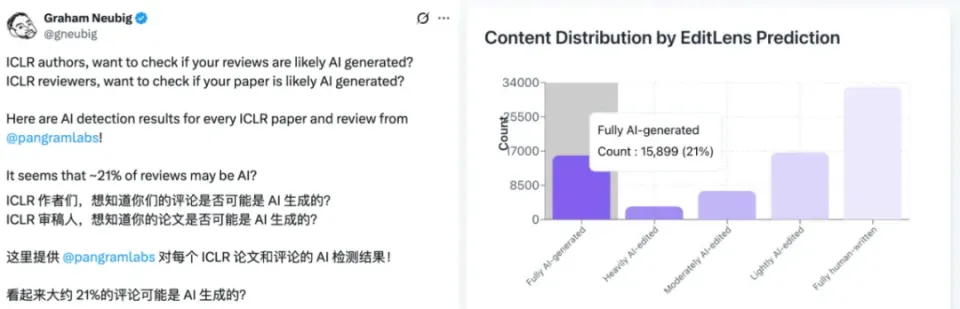

就像我们之前报道的,第三方机构对 ICLR 2026 的审稿意见进行系统性统计,其中就发现了大量 AI 审稿的现象。

在对 75800 篇论文的审稿意见统计中,竟然有 21% 完全由 AI 生成、4% 重度由 AI 编辑、9% 中度由 AI 编辑、22% 轻度由 AI 编辑,完全由人类(审稿人)撰写的仅占 43%。

网友们也表达了类似的意见。AI 审稿已经达到了泛滥的程度,这也并不是 ICML 2026 这次的政策 B 能够完全限制的。

虽然说 ICML 明确规定了使用大模型审稿中不允许存在的行为,但谁又能保证审稿人一定遵从了这些限制呢?我们猜测,用大模型审稿的时候,提问大模型的第一句话就很可能是「给出这篇论文的优缺点」,但这明显是违反规定的。

因此,这套规则或许更像是一种明确态度和方向的约定,而不是一套可以严格执行的机制。

不过,在大家如此担心大模型引发各种信任危机的情况下,ICML 还可以让作者选择拒绝大模型审稿。

有个「一刀切」的选项交到论文作者手中,也是当下一个不错的选择,不是吗?